Débloquer la création vidéo de nouvelle génération avec Alibaba WAN 2.6 sur WaveSpeedAI

Alors que la génération de vidéos IA continue d’évoluer à un rythme rapide, le modèle WAN 2.6 d’Alibaba se distingue comme l’une des solutions open-source les plus avancées disponibles aujourd’hui. Désormais lancé sur WaveSpeedAI, WAN 2.6 permet aux créateurs de raconter des histoires plus captivantes, de générer des vidéos guidées par des références plus intelligentes, et de produire des résultats plus longs et plus expressifs.

Dans cet article, nous mettons en avant les trois fonctionnalités principales qui définissent WAN 2.6 et expliquons pourquoi elles sont importantes pour les créateurs et développeurs modernes.

Fonctionnalité 1 : Génération de narratives multi-scènes

La plupart des modèles vidéo open-source génèrent un seul clip continu, souvent dépourvu de structure ou de cohérence. WAN 2.6 introduit une avancée majeure avec sa capacité à générer des narratives multi-scènes directement à partir d’invites simples.

Le modèle peut :

- diviser intelligemment une invite en plusieurs plans de caméra

- maintenir la cohérence visuelle entre les plans

- préserver les éléments clés comme l’apparence des personnages, l’environnement, l’éclairage et la couleur

- produire une narration cinématographique et cohérente sans contrôle manuel des scènes

Cela rend WAN 2.6 idéal pour les créateurs qui souhaitent des résultats vidéo plus expressifs et riches en narration sans affiner chaque segment.

Fonctionnalité 2 : Génération vidéo basée sur une référence

WAN 2.6 supporte la génération vidéo avec référence, permettant aux utilisateurs de guider le modèle avec une vidéo d’entrée.

Il peut extraire :

- l’apparence des personnages et les traits du visage

- les vêtements, le style et les détails visuels

- les caractéristiques vocales le cas échéant

Il supporte :

- les humains ou n’importe quel objet comme personnage principal

- la génération de référence pour une seule personne

- les scénarios de co-création à deux personnes

Cette capacité déverrouille de nombreuses applications pratiques :

- le contenu d’influenceur avec identité cohérente

- les vidéos de démonstration de produits avec apparence stable

- l’animation d’objets, de jouets ou de personnages stylisés

- la narration axée sur les personnages avec continuité visuelle

Sur WaveSpeedAI, ce flux de travail devient encore plus fluide grâce à notre pipeline de téléchargement de référence rationalisé et de génération préservant l’identité.

référence1 :

référence2 :

Résultat final : (« le personnage 1 dîne avec le personnage 2 dans un restaurant »)

Fonctionnalité 3 : Génération vidéo de 15 secondes

De nombreux modèles open-source sont limités à la production de vidéos très courtes, généralement seulement 2–5 secondes, ce qui restreint la profondeur narrative. WAN 2.6 dépasse cette limite en supportant des vidéos jusqu’à 15 secondes de long.

La durée plus longue permet :

- des arcs narratifs plus complets

- un contenu temporel et spatial plus riche

- des séquences d’action plus fluides

- des transitions multi-scènes au sein d’une seule génération

Cette capacité élargie rend WAN 2.6 approprié pour les clips cinématographiques, les concepts publicitaires, la narration courte, les vitrines de produits et le prototypage créatif.

Avec l’infrastructure optimisée de WaveSpeedAI, même les résultats les plus longs restent stables, cohérents et de haute qualité.

Conseils professionnels : Obtenir les meilleurs résultats avec WAN 2.6 sur WaveSpeedAI

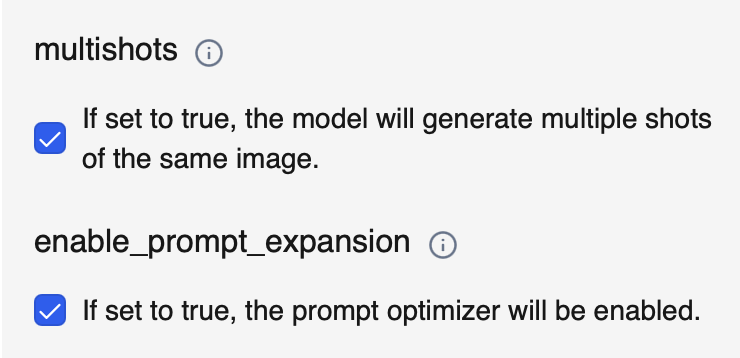

1. Activez « multishots » pour une narration plus riche

L’activation des multishots permet au modèle de générer automatiquement plusieurs plans basés sur votre invite. Cela augmente la profondeur narrative, améliore la variation des scènes et crée des séquences plus cinématographiques sans nécessiter d’ingénierie d’invite complexe.

Utilisez ceci quand vous voulez : une narration multi-scènes, des perspectives dynamiques ou plus de variation cinématographique.

2. Utilisez « enable_prompt_expansion » pour des résultats plus détaillés

Quand enable_prompt_expansion est activé, notre système améliore votre invite d’entrée en ajoutant des détails descriptifs pertinents. Cela aide le modèle à mieux comprendre votre intention et à produire des résultats plus polis, cohérents et visuellement riches.

Utilisez ceci quand vous voulez : des compositions plus claires, une cohérence de style plus forte, ou quand vous pensez que votre invite est trop simple.

Réflexions finales

Alibaba WAN 2.6 apporte des avancées puissantes à la génération vidéo open-source, de la narration multi-scènes à la création guidée par référence et aux vidéos étendues de 15 secondes. Avec le flux de travail optimisé de WaveSpeedAI, ces capacités deviennent encore plus accessibles et efficaces pour les créateurs.

Visitez notre plateforme pour essayer WAN 2.6 vous-même et transformer vos idées en vidéos générées par IA époustouflantes avec facilité.