通过WaveSpeedAI上的阿里巴巴WAN 2.6解锁下一代视频创作

随着AI视频生成技术持续快速发展,阿里巴巴的WAN 2.6 模型脱颖而出,成为当今最先进的开源解决方案之一。现已在WaveSpeedAI上线,WAN 2.6为创作者赋予了更强的叙事能力、更智能的参考驱动生成,以及更长、更富表现力的输出。

在本文中,我们重点介绍了定义WAN 2.6的三个核心功能,并解释了它们为现代创作者和开发者带来的意义。

功能1:多镜头叙事生成

大多数开源视频模型生成单一连续片段,往往缺乏结构或一致性。WAN 2.6通过能够直接从简单提示生成多镜头叙事 引入了一项重大突破。

该模型可以:

- 智能地将提示分解为多个摄像机镜头

- 在镜头间保持视觉一致性

- 保留关键元素,如角色外观、环境、光照和色彩

- 无需手动场景控制即可生成电影级的连贯叙事

这使得WAN 2.6非常适合希望获得更具表现力和叙事丰富的视频输出而无需微调每个片段的创作者。

功能2:基于参考的视频生成

WAN 2.6支持视频参考生成,允许用户用输入视频来引导模型。

它可以提取:

- 角色外观和面部特征

- 服装、风格和视觉细节

- 适用时的语音特征

它支持:

- 人类或任何物体作为主角色

- 单人 参考生成

- 双人 共创场景

此功能释放了许多实际应用:

- 身份一致的影响者内容

- 外观稳定的产品演示视频

- 物体、玩具或风格化角色的动画化

- 具有视觉连贯性的角色驱动叙事

在WaveSpeedAI上,通过我们简化的参考上传和身份保留生成管道,此工作流变得更加顺畅。

参考1:

参考2:

最终结果:(“角色1在餐厅与角色2共进晚餐”)

功能3:15秒长视频生成

许多开源模型仅限于生成极短视频,通常只有2-5秒,这限制了叙事深度。WAN 2.6通过支持长达15秒 的视频突破了这一障碍。

更长的时长使得以下成为可能:

- 更完整的故事弧线

- 更丰富的时间和空间内容

- 更平顺的动作序列

- 单次生成内的多镜头转换

这种扩展的容量使WAN 2.6适合用于电影级片段、广告创意、短篇叙事、产品展示和创意原型开发。

借助WaveSpeedAI的优化基础设施,即使是最长的输出也能保持稳定、连贯和高质量。

专业提示:在WaveSpeedAI上充分利用WAN 2.6

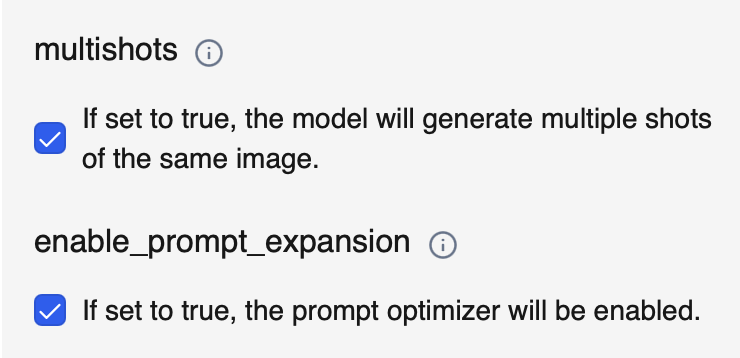

1. 启用”multishots”实现更丰富的叙事

打开multishots 允许模型根据您的提示自动生成多个镜头。这增强了叙事深度、改进了场景变化,并创建了更多电影级的序列,无需复杂的提示工程。

在以下情况下使用: 多场景叙事、动态视角或更多电影级变化。

2. 使用”enable_prompt_expansion”获得更详细的输出

当打开enable_prompt_expansion 时,我们的系统通过添加相关的描述性细节来增强您的输入提示。这有助于模型更好地理解您的意图,并生成更精美、连贯和视觉上丰富的结果。

在以下情况下使用: 需要更清晰的构图、更强的风格一致性,或当您觉得您的提示过于简单时。

最后的思考

阿里巴巴WAN 2.6为开源视频生成带来了强大的进步,从多镜头叙事到参考驱动创意以及扩展的15秒视频。通过WaveSpeedAI的优化工作流,这些功能对创作者来说变得更加易用和有效。

访问我们的平台自己尝试WAN 2.6,轻松将您的创意转化为令人惊艳的AI生成视频。

保持联系

Discord社区 | X (Twitter) | 开源项目 | Instagram