Magi-1 现已登陆WaveSpeedAI

Magi-1 现已在 WaveSpeedAI 上线:开源视频生成的新基准

由 Sand AI 开发的突破性开源视频生成模型 Magi-1 现已在 WaveSpeedAI 上提供实时推理和 API 部署服务。

这个备受好评的发布将视频生成推向新的前沿,结合了最先进的运动质量、时间一致性和视觉保真度——提供了一个强大的开源替代方案,可与专有系统相媲美。

什么是 Magi-1?

Magi-1 是一个大规模扩散型视频生成模型,专门用于从文本提示生成逼真、连贯的视频,支持长达 4 秒的高分辨率帧。由 Sand AI 开发并在开源许可证下发布,它旨在通过与领先的闭源模型相当或超越的性能来民主化视频合成。

其训练策略融合了掩码视频建模、空间-时间一致性学习和多模态对齐,在保持身份、结构和场景逻辑的时间连贯性方面特别强大。

核心特性

扩散视频生成

扩散视频生成 基于去噪扩散概率模型构建,Magi-1 通过逐步将噪声向量序列精化为光度逼真的运动来生成视频。这种方法允许对运动动力学和帧连贯性进行出色的控制。

高质量、时间上一致的运动

与典型的短序列模型(例如 2 秒)不同,Magi-1 生成长达 64 帧(约 4 秒)的视频,同时保持一致的角色身份、背景和动作流。

强大的视觉和结构保真度

该模型擅长渲染详细场景,捕捉细粒度纹理、物体交互和逼真的人体姿势。

多模态条件

Magi-1 支持文本到视频 (T2V) 生成,并在空间和时间维度上进行对齐,使提示驱动的视频创建更精确和可靠。

广泛的基准测试

在公开评估中,Magi-1 在 FVD (Fréchet Video Distance)、人类偏好和身份一致性等关键指标上超越了所有测试的开源模型。参见下面的基准表。

基准比较(来自官方测试)

| 模型 | FVD ↓ (16f) | FVD ↓ (64f) | CLIP-S ↑ | 人类偏好 ↑ |

|---|---|---|---|---|

| Magi-1 | 190.5 | 274.8 | 0.321 | 42.1% |

| Stable Video Diffusion (SVD) | 307.9 | 489.2 | 0.313 | 21.4% |

| Gen-2 (Runway) | 208.4 | 300.6 | 0.317 | 36.5% |

| Pika-LLaVA | 310.3 | 498.7 | 0.307 | 18.6% |

注:FVD 越低越好。CLIP-S 和偏好得分越高表示保真度越高和用户满意度越高。

用途

无论您是在构建生成式工具、创意平台还是实验性媒体,Magi-1 都能实现:

- 电影级视频创作:生成具有引人入胜的运动、场景动态和角色一致性的短视频。

- AI 增强内容:从简单提示创建预告片、概念视觉效果或产品动画。

- 生成式应用原型设计:将 Magi-1 集成到创意工具、游戏和 AIGC 工作流中,用于快速视觉创意。

- 研究与基准测试:为开发下游模型或比较开源框架的研究人员提供强大的基线。

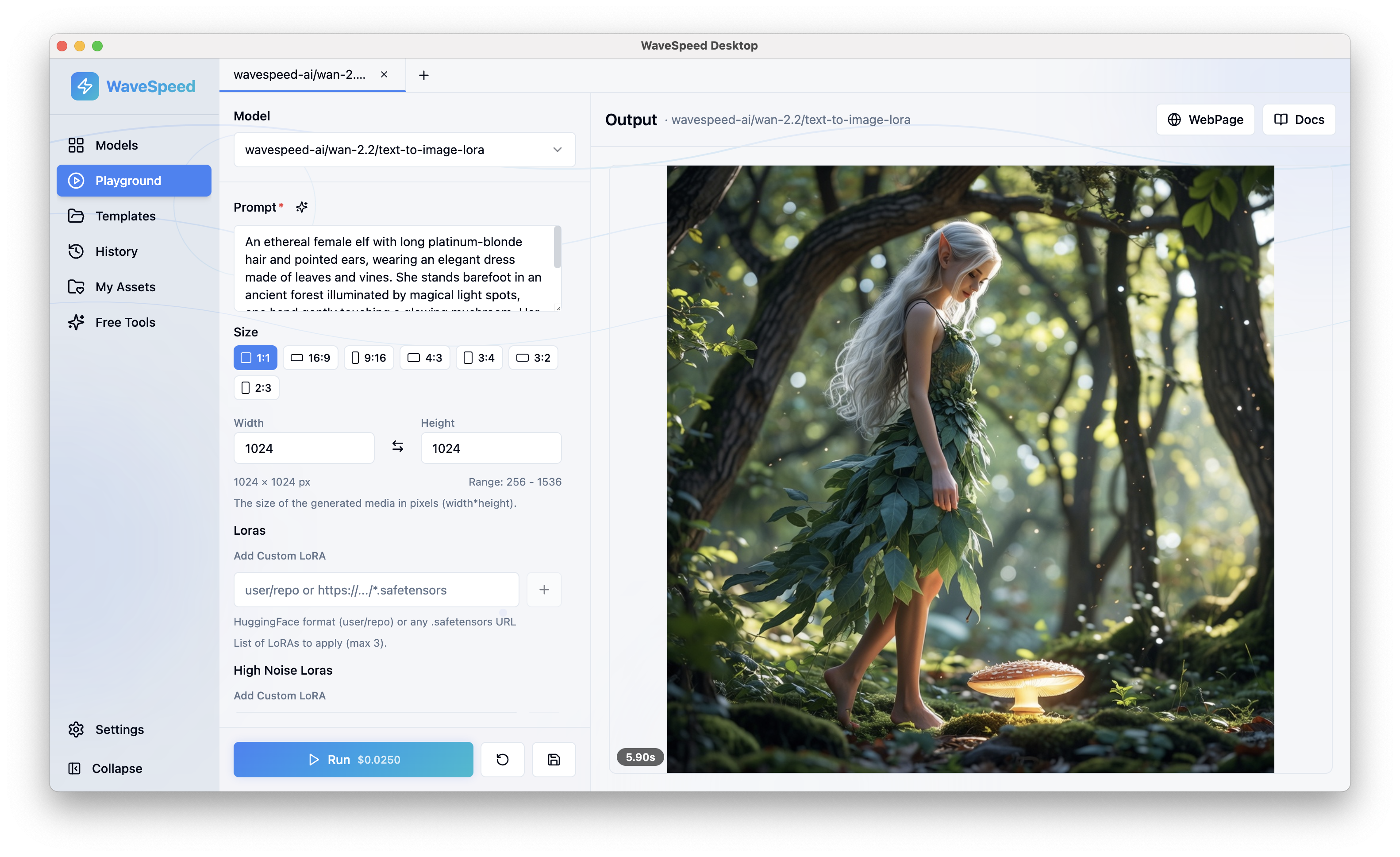

在 WaveSpeedAI 上尝试 Magi-1

Magi-1 现已完全集成到 WaveSpeedAI 的推理引擎中,针对通过 UI 或 API 的响应式视频生成进行了优化。

Magi-1 的发布是开源视频领域的一大进步。它表明高保真、运动一致的视频生成不再被专有系统所垄断。

WaveSpeedAI 很荣幸在我们的平台上发布这一里程碑,帮助将下一代生成式视频带给全球创意工作者、研究人员和开发者社区。