Freepik如何与DataCrunch和WaveSpeed合作,将FLUX媒体生成扩展至每天数百万请求

Freepik 如何通过 DataCrunch 和 WaveSpeed 将 FLUX 媒体生成扩展到每天数百万请求

摘要

自 2024 年初以来,Freepik 一直与 DataCrunch 合作,将最先进的媒体生成技术集成到其 AI Suite 中,并扩展到每天数百万次推理请求。

DataCrunch 为 Freepik 提供了尖端的 GPU 基础设施和托管推理服务,提供以下功能:

- 托管 GPU 编排

- 弹性扩展和近乎零的冷启动

- 通过 WaveSpeed 实现高速度的模型服务

- 直接的专家支持和战略协作联系

Freepik 的客户每月生成超过 6000 万张图像,其中很大一部分请求都通过 DataCrunch 基础设施和服务来实现。

1. 客户概况

Freepik 是一个领先的 AI 驱动的创意套件,它结合了先进的生成式 AI 工具和 2.5 亿多项精选库存资产,以简化高质量内容的创建。

在 2024 年初,Freepik 重新定义了其商业模式,以利用生成式 AI 来创建高质量的媒体内容。Freepik 通过 Stable Diffusion XL 等模型和实验端点开始了其图像生成之旅。进入 2025 年,Freepik 已经改进了其方法,采用了 FLUX 等模型,并扩展到生产级基础设施,同时适应了快速增长的用户群。

Freepik 的 AI Suite 包括一个 AI 图像生成器,它使用 FLUX 等模型从文本提示(T2I)或图像(I2I)生成光真实感的图像,以及一个 AI 视频生成器,由 Google DeepMind Veo 2 等模型驱动,用于从文本或图像创建视频。这些功能设计得很直观,同时优先考虑风格定制和引导工作流程。

- 每月 8000 万访客

- 60 万订阅用户

- 每月生成 6000 万张图像

这些推理请求中的很大一部分涉及 FLUX 模型套件,其推理端点由 DataCrunch 管理,并使用 WaveSpeed 的推理引擎:

- FLUX Dev

- FLUX Tools(例如,修复)

2. 成本高效的媒体生成:FLUX Dev

2.1. 初期挑战

扩展基础设施很少是一项简单的任务。在适应指数级增长的用户群、应对日常使用峰值并优化推理成本和速度的同时扩展基础设施,几乎是不可能的。

当 Freepik 着手建立一个世界级的产品和客户体验时,他们的图像生成基础设施必须处于性能的前沿,同时满足以下要求:

- 将延迟维持在 2-6 秒范围内(p50)

- 优化吞吐量/$ 比(每小时每计算单位的图像)

- 避免与官方未优化基线相比的任何可感知的质量下降

为了满足这些要求,Freepik 必须在效率的最前沿运营,因为即使是几分钱的差异和更优化的每次生成 GPU 利用率也会在这样的规模下带来显著的成本节约。

2.2. 技术方法

通过与 DataCrunch 合作构建和扩展其推理基础设施,Freepik 可以将所有精力集中在改进产品质量和提供世界级的用户体验上。DataCrunch 还使 Freepik 能够适应图像生成领域的快速进步。

DataCrunch 持续在其工程师和 Freepik 之间提供直接沟通,实现了快速协作和调整。这种直接沟通是支持 Freepik 所经历的规模和增长所必需的,并且可以消除任何延迟或误沟通的可能性。

“我们的工程团队之间的直接联系使我们能够以惊人的速度向前推进。能够大规模部署任何模型正是我们在这个快速发展的行业中所需要的。DataCrunch 使我们能够快速轻松地部署自定义模型。”

— Freepik AI 负责人 Iván de Prado

因此,Freepik 在其 AI Suite 中受益于成本高效的模型服务,同时实现了目标吞吐量/$ 和延迟。我们在 DataCrunch 的工作目标是避免”以牺牲一切为代价追求推理速度”的陷阱,这通常会带来输出质量下降和不稳定扩展等权衡。

为了实现这一目标,我们进行了深入的研究,以找到能够保持模型能力的无损优化,然后进行了严格的评估:

- 多指标评估:使用 DreamSim、FID、CLIP、ImageReward 和 Aesthetic 的组合

- 人工评估:Freepik 通过 A/B 竞技场进行了广泛的评估,与基线和其他推理提供商进行了比较。

- 提示多样性:评估了多样化的提示类别,重点关注对象、场景和抽象概念。

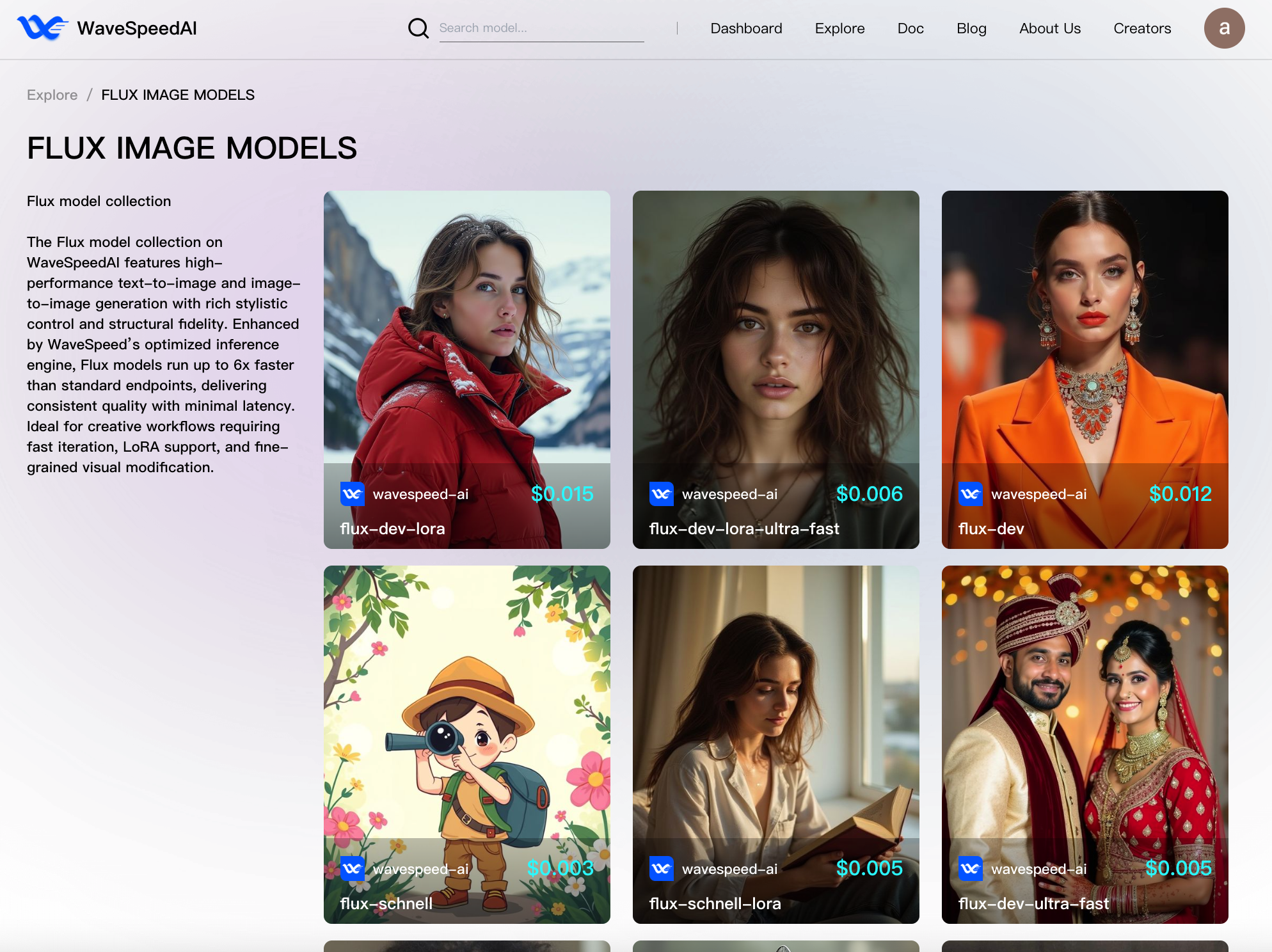

从 2025 年开始,DataCrunch-WaveSpeed 硬件-软件协同设计研究使我们能够进一步推进为 Freepik 提供的最大实际推理效率,同时利用每个组织的核心优势:

- DataCrunch GPU 基础设施和无服务器容器,具有内部 Kubernetes 集群上的自动扩展、高吞吐量网络和低延迟对象存储。

- WaveSpeed 推理引擎,具有内部 ML 编译器、自定义调整和融合的 CUDA 内核、先进的无损量化、DiT 激活缓存(例如 AdaCache)以及开销可忽略不计的轻量级推理服务器。

3. 推理基准测试:方法论和结果

关键指标:平均推理时间和延迟(p99)、每次生成的成本以及每小时的吞吐量。

以下所有结果都是通过 1 个设备的世界大小实现的。优化每个端点以提高效率使我们能够根据 Freepik 在特定时间点的流量和要求(例如用户级别)动态分配可用资源。

| 端点 | 输入参数 | GPU 推理时间(秒) | 每 GPU/小时吞吐量 |

|---|---|---|---|

| flux-dev | 大小 = 1024x1024,步骤 = 28,可选缓存 = 0.1 | 4.4 | 818.2 |

| flux-dev-fast | 大小 = 1024x1024,步骤 = 28,可选缓存 = 无 | 3.3 | 1091 |

| flux-dev-fast | 大小 = 1024x1024,步骤 = 28,可选缓存 = 0.1 | 2.2 | 1636 |

| flux-dev-fast | 大小 = 1024x1024,步骤 = 28,可选缓存 = 无 | 1.64 | 2184 |

| flux-dev-ultra | 大小 = 1024x1024,步骤 = 28,可选缓存 = 无 | 1.648 | 2184 |

| flux-dev-ultra | 大小 = 1024x1024,步骤 = 28,可选缓存 = 0.1 | 1.045 | 3445 |

| flux-dev-ultra | 大小 = 1024x1024,步骤 = 28,可选缓存 = 0.16 | 0.768 | 4688 |

4. 技术解决方案:生产级 GPU 基础设施

DataCrunch GPU 基础设施为大规模生成式 AI 系统提供了生产级基础,WaveSpeed 优化引擎进一步推进了效率的界限。

- 托管 GPU 编排:GPU 细粒度资源管理通过内部 Kubernetes 集群提供,允许 WaveSpeed 控制推理的资源分配,而无需担心基础设施管理或深入探讨基础设施即代码。

- 弹性扩展:无服务器容器被定制为根据传入请求的数量从零自动扩展到超过 500 个 GPU 实例。这种能力对于吸收日常流量峰值、防止排队或丢弃请求以及在闲置时扩展为零以避免不必要的成本至关重要。

- 近乎零的冷启动:冷启动延迟通过预热编译、更快的镜像拉取时间和容器缓存得到显著降低,接近了 GPU 工作负载的真正 lambda 性能。

- 高速度的模型服务:优化的存储和网络构造显著减少了加载模型权重和拉取 Docker 镜像所花费的时间。这对于 FLUX LoRA 部署尤其关键,因为 LoRA 权重需要缓存并移动到每个 GPU 实例。此外,DataCrunch 共享文件系统进一步提高了模型服务速度,并通过让多个实例读写同一个集中式文件存储库来减少数据传输开销。

5. 业务成果:成本节约和战略优势

DataCrunch 与 WaveSpeed 联手,使 Freepik 能够通过 FLUX Dev 模型扩展图像生成,同时将推理成本降至最低。

除了直接的成本节约,战略合作还使 Freepik 的大部分用户能够以更高的生成配额访问 FLUX 模型。

DataCrunch 团队严格评估并确保了输出质量,同时通过应用硬件感知优化来利用异构计算基础设施。

关键的收获之一是,可持续和可扩展的推理需要从不同角度理解 ML 系统:

- GPU 感知优化(例如 B200 自定义 CUDA 内核)

- 严格的测试和评估

- 基础设施集成(即自动扩展、零冷启动、网络调优)

随着 Freepik 目标实现更高的流量和推理量,推出新的企业计划,DataCrunch 将继续应用这种成功的方法来实现持续的扩展性能。

6. 未来预测:媒体生成的下一步是什么

从文本提示或图像调节生成图像已不足以满足专业环境中对控制和编辑功能日益增长的需求,这些专业环境由数字艺术家和广告代理机构使用。

Black Forest Labs 推出 FLUX 后,在图像生成质量方面实现了巨大飞跃。我们预期 FLUX.1 Kontext [dev] 将对图像编辑产生类似的拐点效应,其采用率将超过 FLUX 模型。

OpenAI 4o 图像生成等故事证实了对具有高度可操纵性、与输入图像轻松调节、字符一致性和强大提示依从性的模型有很高的需求。

Black Forest Labs 通过发布 FLUX.1 Kontext [max] 和 [pro],证明了他们能够再现这些功能,同时更具成本效益。

展望未来,DataCrunch 计划超越图像生成,走向端到端工作流程。正在进行的研究和开发项目重点关注:

- 使用 Alibaba WAN 2.1 和 VACE 等模型进行 SOTA 视频生成的可扩展且具有成本效益的集成

- 图像和视频升级采样模型

- 降低构建代理媒体产品的复杂性

- 在 DataCrunch 云平台中发布 FLUX Dev(基础模型、LoRA、工具)推理端点 – 敬请期待

现在尝试 FLUX Dev 和更多模型!