Представляем WaveSpeedAI Any LLM Vision на WaveSpeedAI

Попробовать Wavespeed Ai Any Llm Vision БЕСПЛАТНО

Представляем Any Vision LLM: унифицированный доступ к лучшим мультимодальным моделям ИИ в мире

Ландшафт ИИ резко эволюционировал, и модели зрения и языка (VLM) стали незаменимыми инструментами для предприятий и разработчиков по всему миру. Сегодня WaveSpeedAI представляет Any Vision LLM—революционный шлюз, дающий вам мгновенный доступ к отобранному каталогу самых мощных мультимодальных моделей через единый унифицированный API на основе OpenRouter.

Больше не нужно жонглировать несколькими ключами API. Больше не нужно переключаться между провайдерами. Просто одна конечная точка для доступа к GPT-4o, Claude 3.5, Gemini 2.5, Qwen3-VL, Llama 4 и десяткам других передовых моделей зрения и языка.

Что такое Any Vision LLM?

Any Vision LLM — это гибкое решение WaveSpeedAI для мультимодального вывода, которое соединяет вас с обширным каталогом моделей зрения и языка. Построенный на надежной инфраструктуре OpenRouter, этот сервис позволяет вам легко переключаться между различными VLM в зависимости от вашего конкретного случая использования — будь то научное рассуждение GPT-4o, понимание документов Qwen3-VL или многоязычные мультимодальные возможности Gemini 2.5 Pro.

Ландшафт VLM в 2025 году более конкурентный, чем когда-либо. Модели с открытым исходным кодом, такие как Qwen2.5-VL-72B, теперь показывают производительность на уровне 5-10% от проприетарных моделей, а новые релизы, такие как Llama 4 Maverick, предлагают контекстные окна с 1 миллионом токенов. С Any Vision LLM вы получаете доступ ко всей этой экосистеме без сложности управления несколькими интеграциями.

Ключевые возможности

Унифицированный доступ через API

- Одна конечная точка для всех моделей зрения и языка в каталоге

- Совместимый с OpenAI интерфейс для легкой интеграции с существующими рабочими процессами

- Автоматическая маршрутизация моделей на основе ваших требований

Обширный каталог моделей

Доступ к ведущим VLM, включая:

- GPT-4o — 59,9% точности на контрольных показателях MMMU-Pro, отлично подходит для научного рассуждения

- Claude 3.5 Sonnet — обрабатывает сложные макеты в контексте 200 000 токенов

- Gemini 2.5 Pro — в настоящее время лидирует в рейтингах LMArena для зрения и кодирования

- Qwen3-VL — собственный контекст 256K, расширяемый до 1 миллиона токенов, с агентскими возможностями

- Llama 4 Maverick — 17B активных параметров с контекстным окном в 1 миллион токенов

- Варианты с открытым исходным кодом — Qwen2.5-VL, InternVL3, Molmo и другие

Готовая к производству инфраструктура

- Без холодных запусков — модели всегда теплые и готовы к работе

- Быстрый вывод — оптимизирован для низкой задержки

- Доступное ценообразование — платите только за то, что используете

- Время безотказной работы 99,9% — надежность корпоративного уровня

Гибкий мультимодальный ввод

- Обрабатывайте изображения, скриншоты, документы и диаграммы

- Поддержка многоизображениевых диалогов

- Поддержка PDF и сложных визуальных макетов

- Многоязычное распознавание текста на изображениях на 30+ языках

Примеры использования в реальном мире

Интеллект документов и распознавание текста

Извлекайте структурированные данные из счетов-фактур, контрактов и форм. Продвинутое понимание документов Qwen3-VL обрабатывает научный визуальный анализ, интерпретацию диаграмм и многоязычное распознавание текста с исключительной точностью. Обрабатывайте тысячи документов без ручного ввода данных.

Автоматизация поддержки клиентов

Создавайте агентов поддержки, которые понимают скриншоты, сообщения об ошибках и изображения продуктов. Когда пользователи делятся фото неисправного устройства, ваш ИИ может определить компоненты, диагностировать проблемы и предоставить пошаговые решения — все в одном взаимодействии.

Электронная коммерция и визуальный поиск

Улучшайте обнаружение товаров с помощью поиска на основе изображений и рекомендаций. Организации, использующие мультимодальный визуальный поиск, видели улучшение коэффициента кликов на страницах товаров на 14,2% и увеличение добавления в корзину на 8,1%.

Модерирование и анализ контента

Автоматически рецензируйте пользовательский контент на изображениях и текстах. Обнаруживайте нарушения политики, оценивайте качество и категоризируйте контент в масштабе с моделями, которые понимают контекст и нюансы.

Медицинские и медико-санитарные приложения

Поддерживайте клинические рабочие процессы, объединяя медицинские изображения с примечаниями пациента. VLM могут анализировать рентгеновские снимки, интерпретировать результаты лабораторных анализов и помогать с диагностическими предложениями — всегда под наблюдением врача.

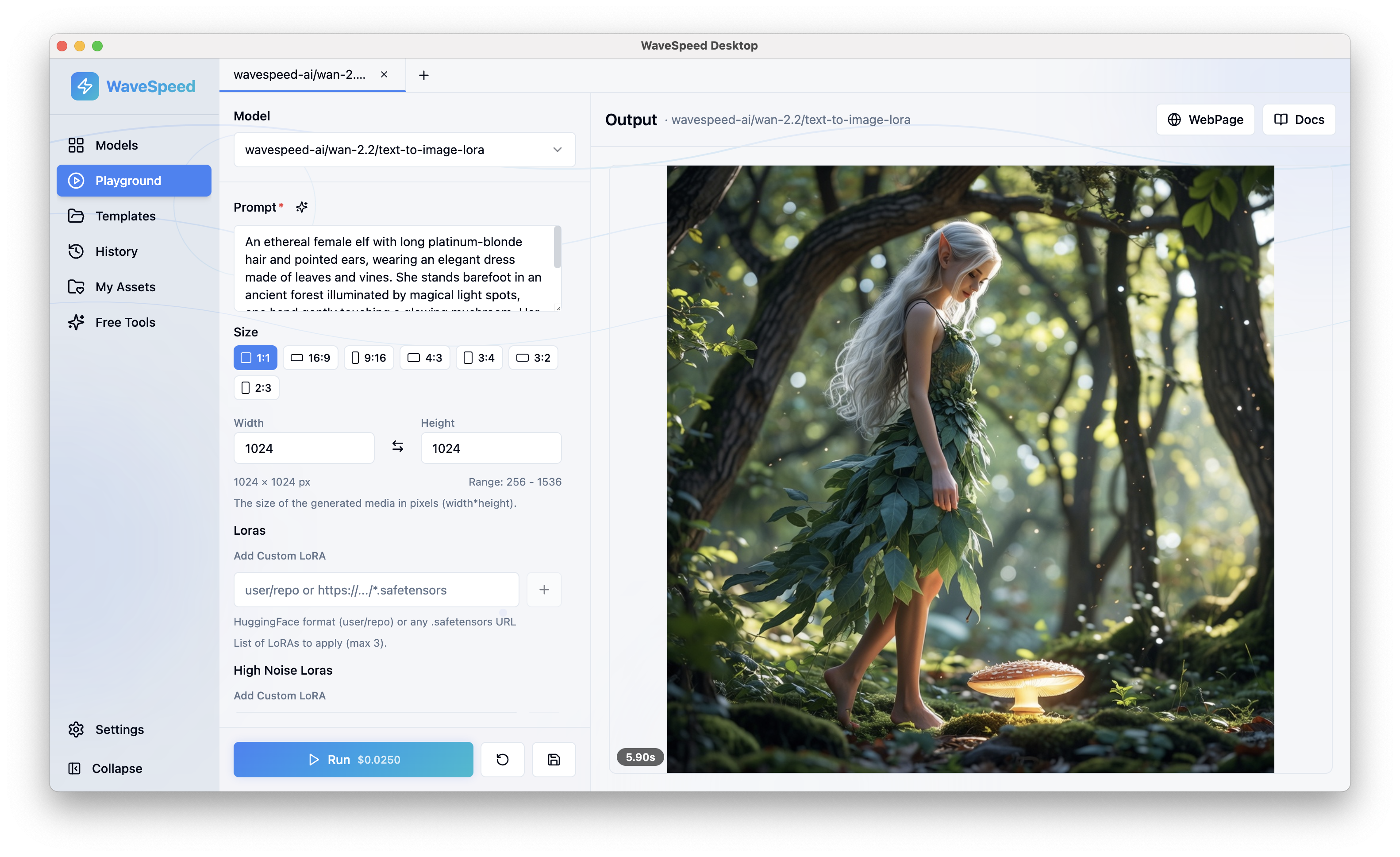

Разработка программного обеспечения и помощь в интерфейсах

Превращайте эскизы и макеты в код. Qwen3-VL и похожие модели могут интерпретировать дизайны интерфейсов, отлаживать визуальные интерфейсы и помогать с рабочими процессами разработки программного обеспечения, где скриншоты требуют быстрой интерпретации.

Полевые операции и обслуживание

Расширяйте возможности работников на передовой с помощью помощи в реальном времени. Когда техники фотографируют проблемы с оборудованием, мультимодальный ИИ может определить части, аннотировать проблемы, извлечь руководства и мгновенно направить ремонт.

Начнем с WaveSpeedAI

Интеграция Any Vision LLM в ваше приложение занимает минуты:

1. Получите ваш ключ API

Зарегистрируйтесь в WaveSpeedAI и создайте свои учетные данные API на панели управления.

2. Сделайте свой первый запрос

Используйте нашу совместимую с OpenAI конечную точку для отправки изображений и текста:

import wavespeed

output = wavespeed.run(

"wavespeed-ai/any-llm/vision",

{

"messages": [

{

"role": "user",

"content": [

{"type": "text", "text": "What's in this image?"},

{"type": "image_url", "image_url": {"url": "https://..."}},

],

}

],

},

)

print(output["outputs"][0]) # Response text3. Выберите вашу модель

Укажите, какой VLM использовать на основе ваших требований — требуется ли вам максимальная точность, самый быстрый ответ или оптимизация затрат.

Почему выбрать WaveSpeedAI для мультимодального вывода?

Производительность без компромиссов Наша инфраструктура оптимизирована для мультимодальных рабочих нагрузок. Методы, такие как квантование FP8, обеспечивают улучшение скорости до 2-3 раз при сохранении качества модели.

Гибкость в масштабе Переключайтесь между моделями без изменения кода. Протестируйте GPT-4o для точности, а затем разверните альтернативу с открытым исходным кодом для экономии затрат — все через один API.

Готово для предприятия С временем безотказной работы 99,9%, полным логированием и аналитикой использования, WaveSpeedAI создан для производственных рабочих нагрузок. Отсутствие холодных запусков означает, что ваши приложения отвечают мгновенно, каждый раз.

Экономичный Избегайте затрат на инфраструктуру самостоятельного размещения нескольких VLM. Платите за запрос с прозрачным ценообразованием и без скрытых сборов.

Будущее мультимодального ИИ уже здесь

Разрыв между проприетарными и открытыми VLM быстро сокращается. Модели, такие как Qwen3-VL, теперь конкурируют с GPT-4o и Gemini 2.5 Pro по контрольным показателям, в то время как легкие варианты, такие как Phi-4, приносят мультимодальные возможности на пограничные устройства.

С Any Vision LLM на WaveSpeedAI вы не привязаны к одной модели или провайдеру. По мере развития ландшафта VLM ваши приложения автоматически получают доступ к последним и лучшим моделям — без необходимости миграции.

Начните строить сегодня

Готовы добавить мощные возможности зрения и языка в ваши приложения? Any Vision LLM дает вам мгновенный доступ к лучшим мультимодальным моделям в мире через единый надежный API.

Попробуйте Any Vision LLM на WaveSpeedAI →

Присоединяйтесь к тысячам разработчиков, которые доверяют WaveSpeedAI для быстрого, доступного и надежного вывода ИИ. Без холодных запусков. Без сложности. Только результаты.