Как Freepik масштабировала FLUX медиа-генерацию до миллионов запросов в день с помощью DataCrunch и WaveSpeed

Как Freepik масштабировала генерацию медиа FLUX до миллионов запросов в день с помощью DataCrunch и WaveSpeed

Резюме

С начала 2024 года Freepik сотрудничает с DataCrunch для интеграции современной генерации медиа в свой AI Suite и масштабирования обработки миллионов запросов на выполнение операций в день. DataCrunch предоставляет Freepik передовую инфраструктуру GPU и управляемые сервисы выполнения операций, обеспечивая следующие возможности:

- Управляемая оркестрация GPU

- Эластичное масштабирование и почти нулевые холодные запуски

- Высокоскоростное обслуживание моделей с WaveSpeed

- Прямой контакт для экспертной поддержки и стратегического сотрудничества Клиенты Freepik генерируют более 60 миллионов изображений в месяц, и значительная часть этих запросов стала возможной благодаря инфраструктуре и сервисам DataCrunch.

1. Профиль клиента

Freepik — это ведущий AI-ориентированный набор инструментов для творчества, который объединяет передовые инструменты генеративного AI с 250 млн+ отобранных стоковых активов для упрощения создания высокачественного контента.

В начале 2024 года Freepik переопределила свою бизнес-модель, чтобы использовать генеративный AI для создания высокачественного медиа-контента. Freepik начала свой путь в генерацию изображений с моделей, таких как Stable Diffusion XL, и экспериментальных endpoint. Направляясь в 2025 год, Freepik уточнила свой подход, приняв модели, такие как FLUX, и масштабируясь на производственную инфраструктуру одновременно с быстро растущей пользовательской базой.

AI Suite Freepik включает AI Image Generator, который использует модели, такие как FLUX, для создания фотореалистичных изображений из текстовых подсказок (T2I) или изображений (I2I), и AI Video Generator, поддерживаемый моделями, такими как Google DeepMind Veo 2, для создания видео из текста или изображений. Эти функции были разработаны для интуитивного использования при приоритизации настройки стиля и управляемых рабочих процессов.

AI Suite Freepik получила более:

- 80 миллионов посетителей в месяц

- 600 тысяч подписанных пользователей

- 60 миллионов сгенерированных изображений в месяц

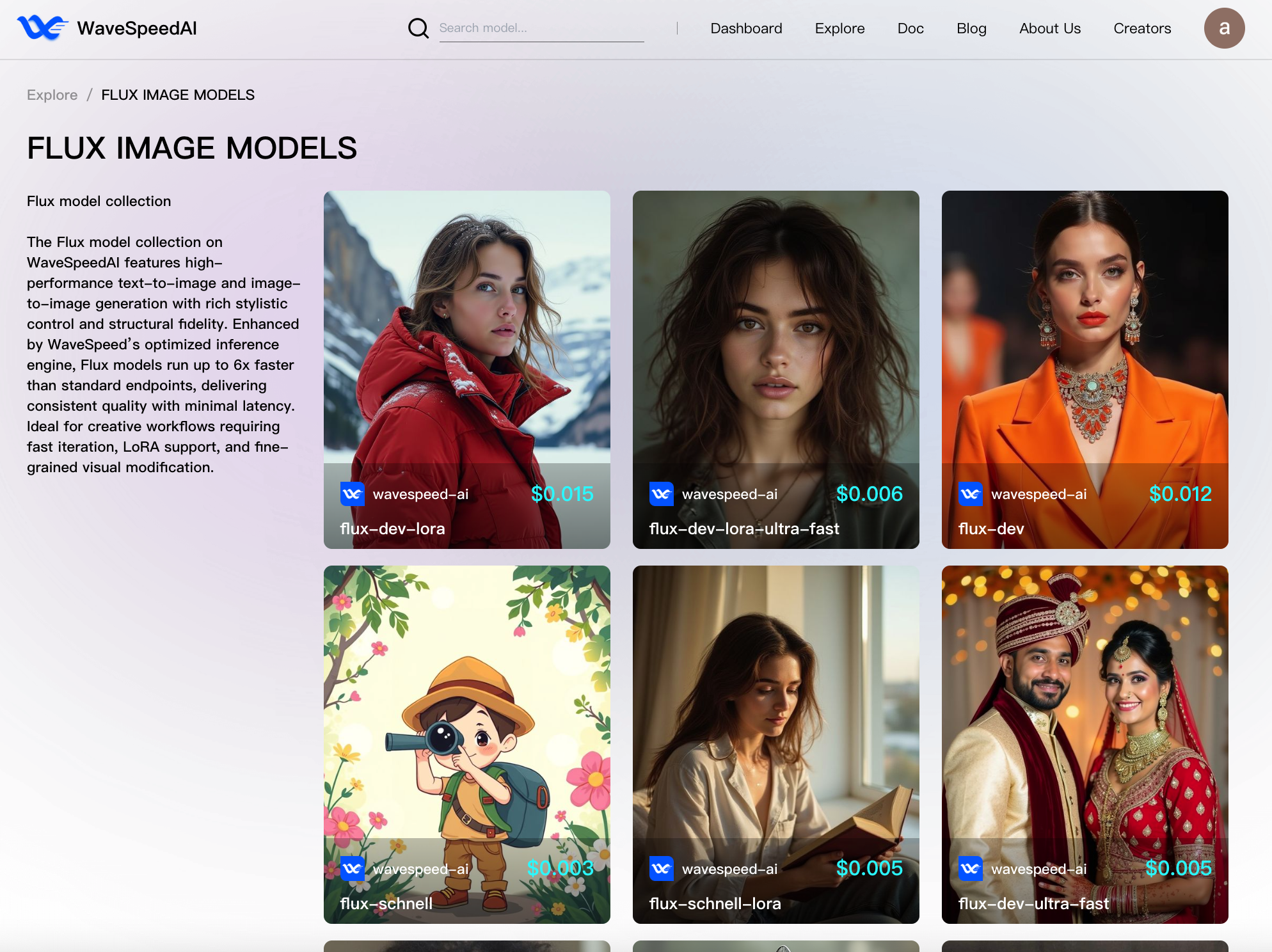

Значительная часть этих запросов на выполнение операций включает набор моделей FLUX с endpoint выполнения операций, управляемыми DataCrunch и использующими механизм выполнения операций от WaveSpeed:

- FLUX Dev

- FLUX Tools (например, inpainting)

2. Эффективная генерация медиа с точки зрения затрат: FLUX Dev

2.1. Начальные вызовы

Масштабирование инфраструктуры редко бывает легкой задачей. Масштабирование инфраструктуры при одновременном размещении экспоненциально растущей пользовательской базы, учитывающее дневные всплески использования и оптимизирующее стоимость и скорость выполнения операций, почти невозможно. Когда Freepik приступила к разработке мирового класса продукта и пользовательского опыта, их инфраструктура генерации изображений должна была быть на переднем крае производительности при соблюдении следующих требований:

- Поддержание задержки ниже диапазона 2-6 секунд (p50)

- Оптимизация пропускной способности/$ (изображение в час на вычисление)

- Избежание любой заметной регрессии качества по сравнению с официальной неоптимизированной базовой версией

Для выполнения этих требований Freepik должна была работать на переднем крае эффективности, так как даже доли цента и более оптимальное использование GPU на поколение привели бы к значительным экономиям затрат в таком масштабе.

2.2. Технический подход

Работая с DataCrunch над разработкой и масштабированием своей инфраструктуры выполнения операций, Freepik может сосредоточить все свои усилия на улучшении качества продукта и предоставлении мирового класса пользовательского опыта. DataCrunch также позволила Freepik адаптироваться к быстрым достижениям в генерации изображений. DataCrunch постоянно обеспечивала прямое общение между своими инженерами и Freepik, позволяя быстрое сотрудничество и корректировки. Это прямое общение было необходимо для поддержки масштабирования и роста, который испытала Freepik, и для устранения любых задержек или возможности неправильного общения.

«Прямой контакт между нашими инженерными командами позволяет нам двигаться невероятно быстро. Возможность развертывания любой модели в масштабе — это именно то, что нам нужно в этой быстро меняющейся отрасли. DataCrunch позволяет нам развертывать пользовательские модели быстро и без усилий.» – Iván de Prado, Head of AI в Freepik

В результате Freepik получила выгоду от эффективной с точки зрения затрат обслуживания моделей в своем AI Suite при достижении целевой пропускной способности/$ и задержки. Наши усилия в DataCrunch были направлены на избежание ловушки «скорость выполнения операций любой ценой», которая обычно связана с компромиссами, такими как деградация выходных данных и нестабильное масштабирование. Для достижения этого мы провели углубленные исследования в области безщадных оптимизаций, которые сохраняют возможности моделей, за которыми последовала тщательная оценка:

- Многометровая оценка: Использование комбинации DreamSim, FID, CLIP, ImageReward, и Aesthetic

- Человеческая оценка: Freepik провела обширную оценку через A/B арены, сравнивая с базовой версией и другими поставщиками услуг выполнения операций.

- Разнообразие подсказок: Оценка разнообразных категорий подсказок с фокусом на объекты, сцены и абстрактные концепции.

Начиная с 2025 года, исследование сокристаллизма HW-SW DataCrunch-WaveSpeed позволило нам еще больше повысить максимальную практическую эффективность выполнения операций, предлагаемую Freepik, при этом используя основные сильные стороны каждой организации:

- Инфраструктура GPU DataCrunch и Serverless Containers с автоматическим масштабированием на внутреннем кластере Kubernetes, высокопропускной сетью и низколатентным хранилищем объектов.

- Механизм выполнения операций WaveSpeed с встроенным компилятором ML, пользовательскими настроенными и объединенными CUDA ядрами, передовым безщадным квантованием, кешированием активации DiT (например, AdaCache), и легкими серверами выполнения операций с незначительными издержками.

3. Бенчмарк выполнения операций: методология и результаты

Ключевые метрики: среднее время выполнения операций и задержка (p99), стоимость за поколение и пропускная способность в час.

Все следующие результаты были достигнуты с размером мира в 1 устройство. Оптимизация каждого endpoint для эффективности позволила нам динамически выделять доступные ресурсы на основе трафика Freepik в конкретный момент времени и требований (например, уровни пользователей).

| Endpoint | Параметры входа | Время вывода GPU (сек) | пропускная способность на GPU/ч |

|---|---|---|---|

| flux-dev | Size = 1024x1024, steps = 28, optional cache = 0.1 | 4.4 | 818.2 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = None | 3.3 | 1091 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = 0.1 | 2.2 | 1636 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = None | 1.64 | 2184 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = None | 1.648 | 2184 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = 0.1 | 1.045 | 3445 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = 0.16 | 0.768 | 4688 |

4. Техническое решение: производственная инфраструктура GPU

Инфраструктура GPU DataCrunch обеспечивает производственную основу для крупномасштабных систем генеративного AI с механизмом оптимизации WaveSpeed, еще больше повышающим конверт эффективности.

- Управляемая оркестрация GPU: управление ресурсами GPU с мелкозернистостью обеспечивается через внутренний кластер Kubernetes, позволяя WaveSpeed контролировать выделение ресурсов для выполнения операций без беспокойства об управлении инфраструктурой или углублении в Infrastructure-as-Code.

- Эластичное масштабирование: Serverless Containers были настроены для автоматического масштабирования от нуля до более чем 500 экземпляров GPU на основе количества входящих запросов. Эта возможность имеет решающее значение для поглощения суточных всплесков трафика без очередей или отброса запросов, а также масштабирования до нуля в режиме ожидания, чтобы избежать ненужных затрат.

- Почти нулевые холодные запуски: задержка холодного запуска была значительно сокращена благодаря предварительному разогреву компиляций, более быстрым временам извлечения образов и кешированию контейнеров, приблизившись к истинной производительности lambda для рабочих нагрузок GPU.

- Высокоскоростное обслуживание моделей: оптимизированное хранилище и сетевые ткани значительно сократили время, потраченное на загрузку весов модели и извлечение образов Docker. Это особенно важно для развертываний FLUX LoRA, поскольку веса LoRA необходимо кешировать и перемещать на каждый экземпляр GPU. Кроме того, общая файловая система DataCrunch еще больше увеличивает скорость обслуживания моделей и снижает накладные расходы передачи данных, позволяя нескольким экземплярам читать и писать в один централизованный хранилище файлов.

5. Бизнес-результаты: экономия затрат и стратегические преимущества

DataCrunch, совместно работая с WaveSpeed, позволила Freepik масштабировать генерацию изображений с моделями FLUX Dev при минимизации затрат на выполнение операций. В дополнение к прямой экономии затрат, стратегическое партнерство позволило значительной доле пользователей Freepik получить доступ к моделям FLUX с более высокими квотами генерации. Команда DataCrunch тщательно оценила и обеспечила качество выходных данных при использовании разнородной инфраструктуры вычислений путем применения оптимизаций, учитывающих аппаратное обеспечение. Одним из ключевых выводов было то, что устойчивое и масштабируемое выполнение операций требует понимания систем ML с разных перспектив:

- Оптимизации, учитывающие GPU (например, B200 пользовательские CUDA ядра)

- Тщательное тестирование и оценка

- Интеграция инфраструктуры (то есть автоматическое масштабирование, нулевые холодные запуски, настройка сети) По мере того как Freepik стремится к более высокому трафику и объемам выполнения операций со своим новым планом для предприятий, DataCrunch будет продолжать применять этот успешный подход для достижения продолжающегося масштабирования производительности.

6. Прогнозы на будущее: что дальше для генерации медиа

Генерация изображений из текстовых подсказок или кондиционирования изображения оказалась недостаточной для удовлетворения растущего спроса на возможности управления и редактирования в профессиональных средах, используемых цифровыми художниками и рекламными агентствами. С выпуском FLUX Black Forest Labs сделала гигантский скачок в качестве генерации изображений. Мы ожидаем, что FLUX.1 Kontext [dev] создаст аналогичную точку перелома для редактирования изображений с уровнями внедрения, превосходящими уровни модели FLUX. Истории, такие как OpenAI 4o генерация изображений, подтверждают, что существует высокий спрос на модели с высокой степенью управляемости, легкого кондиционирования входными изображениями, согласованности персонажей и сильной приверженности подсказкам. С выпуском FLUX.1 Kontext [max] и [pro] Black Forest Labs продемонстрировала, что она способна воспроизводить такие возможности при меньших затратах. Глядя вперед, DataCrunch планирует выйти за рамки генерации изображений и перейти к сквозным рабочим процессам. Текущие проекты исследований и разработок сосредоточены на:

- Масштабируемая и экономичная интеграция генерации видео на уровне SOTA с моделями, такими как Alibaba WAN 2.1 и VACE

- Модели увеличения масштаба изображений и видео

- Снижение сложности создания средств массовой информации агентского продукта

- Выпуск endpoint выполнения операций FLUX Dev (базовая модель, LoRA, инструменты) на платформе облака DataCrunch — следите за обновлениями

Попробуйте FLUX Dev и другие модели уже сейчас!

🔗FLUX-dev

🔗FLUX-dev-ultra-fast

🔗FLUX-dev-lora

🔗Коллекция модели FLUX

🔗Wan-2.1-14b-vace

🔗Seedance 1.0

Следите за нами в Twitter, LinkedIn и присоединяйтесь к нашему каналу Discord, чтобы быть в курсе.