Présentation de Sync LipSync 1.9.0 Beta sur WaveSpeedAI

Essayer Sync Lipsync.1.9.0 Beta GRATUITEMENTSync Labs Lipsync 1.9.0 Beta est maintenant disponible sur WaveSpeedAI : synchronisation labiale zéro-shot qui fonctionne simplement

L’avenir du doublage vidéo et de la synchronisation labiale est arrivé. WaveSpeedAI est ravi d’annoncer la disponibilité de Sync Labs Lipsync 1.9.0 Beta—le modèle de synchronisation labiale zéro-shot que Sync Labs a qualifié de « plus grande mise à jour de notre gamme de modèles de notre histoire » et « le modèle de synchronisation labiale le plus naturel du monde ».

Que vous soyez un cinéaste localisant du contenu pour des audiences internationales, un créateur de contenu construisant des campagnes multilingues sur les réseaux sociaux, ou un développeur intégrant la synchronisation labiale dans des workflows de production, ce modèle offre des résultats de qualité studio sans la complexité traditionnelle des données d’entraînement ou des ajustements manuels.

Qu’est-ce que Sync Labs Lipsync 1.9.0 Beta ?

Sync Labs, l’équipe soutenue par Y Combinator derrière le modèle open-source fondateur Wav2Lip (étoilé plus de 11 000 fois sur GitHub), a construit Lipsync 1.9.0 Beta comme une repensée complète de la façon dont la synchronisation labiale devrait fonctionner.

Contrairement aux modèles de génération précédente qui utilisaient des pipelines multi-étages—où les erreurs s’accumulaient au fur et à mesure que la vidéo passait d’une étape de traitement à une autre—Lipsync 1.9.0 Beta fonctionne comme un monolithe end-to-end en un seul coup. Cette percée architecturale élimine la dégradation de qualité qui affligeait les approches antérieures.

Le modèle est zéro-shot, ce qui signifie que vous n’avez besoin d’aucune donnée d’entraînement pour l’utiliser efficacement. Que vous ayez une heure de matériel ou seulement quelques secondes, vous pouvez générer des mouvements labiaux naturels qui correspondent à n’importe quelle piste audio—à travers des images en direct, l’animation stylisée et la vidéo générée par l’IA.

Caractéristiques clés

-

Traitement zéro-shot : Aucun entraînement, fine-tuning ou clip de référence requis. Téléchargez votre vidéo et audio, et le modèle gère tout automatiquement.

-

Édition consciente du style : Le modèle ajuste uniquement la région de la bouche tout en préservant l’identité du locuteur, les conditions d’éclairage et l’arrière-plan—maintenant la continuité visuelle tout au long.

-

Support multi-domaine : Fonctionne de manière transparente sur les images en direct, l’animation CG au niveau Pixar, les personnages stylisés et les visages générés par l’IA sans changer de modèle ou ajuster les paramètres.

-

Contrôle de synchronisation flexible : Cinq modes de synchronisation (loop, bounce, cut_off, silence, remap) vous permettent de contrôler exactement comment le modèle gère les décalages de durée entre vos pistes vidéo et audio.

-

Intégration faciale naturelle : Plutôt que de simplement remplacer la moitié inférieure du visage comme les modèles traditionnels, Lipsync 1.9.0 Beta comprend comment le visage entier se déplace pendant la parole—parce que les expressions faciales sont des mouvements complexes et interdépendants.

-

Détection du locuteur actif : Le pipeline de pointe du modèle peut gérer de longues vidéos avec plusieurs locuteurs, en associant automatiquement chaque voix unique au visage correct.

Cas d’usage réels

Production de films et vidéos

Distribution internationale : Sortez un seul film dans plusieurs langues pour les plateformes de streaming mondiales. Le modèle préserve la performance émotionnelle de vos acteurs originaux tout en synchronisant le dialogue traduit—pas besoin de réassembler la distribution pour les sessions d’ADR.

Remplacement de dialogue en post-production : Avez-vous besoin de réviser un scénario après le tournage principal ? Enregistrez de nouvelles lignes et laissez l’IA les faire correspondre parfaitement aux images existantes, éliminant les reprises coûteuses.

Accessibilité documentaire : Rendez les interviews du monde réel accessibles à des audiences plus larges sans l’effet uncanny valley du doublage traditionnel.

Création de contenu et marketing

Localisation des réseaux sociaux : Créez des TikToks, des Reels et des YouTube Shorts qui parlent directement aux audiences dans leur langue maternelle. Une vidéo maître peut générer des dizaines de versions localisées en minutes.

Campagnes vidéo personnalisées : Échangez les pistes audio pour adapter les messages à différents segments de clients sans tourner du nouveau contenu. Mettez à jour les vidéos de porte-parole saisonnièrement sans ramener le talent sur le plateau.

E-Learning et formation : Traduisez les vidéos d’intégration, de formation et éducatives tout en maintenant la livraison naturelle qui garde les apprenants engagés.

Intégration pour développeurs

L’API REST du modèle facilite l’intégration pour les développeurs construisant des pipelines de doublage, des outils d’édition vidéo ou des plateformes de localisation de contenu. Traitez les vidéos par programmation à grande échelle avec des résultats cohérents et professionnels.

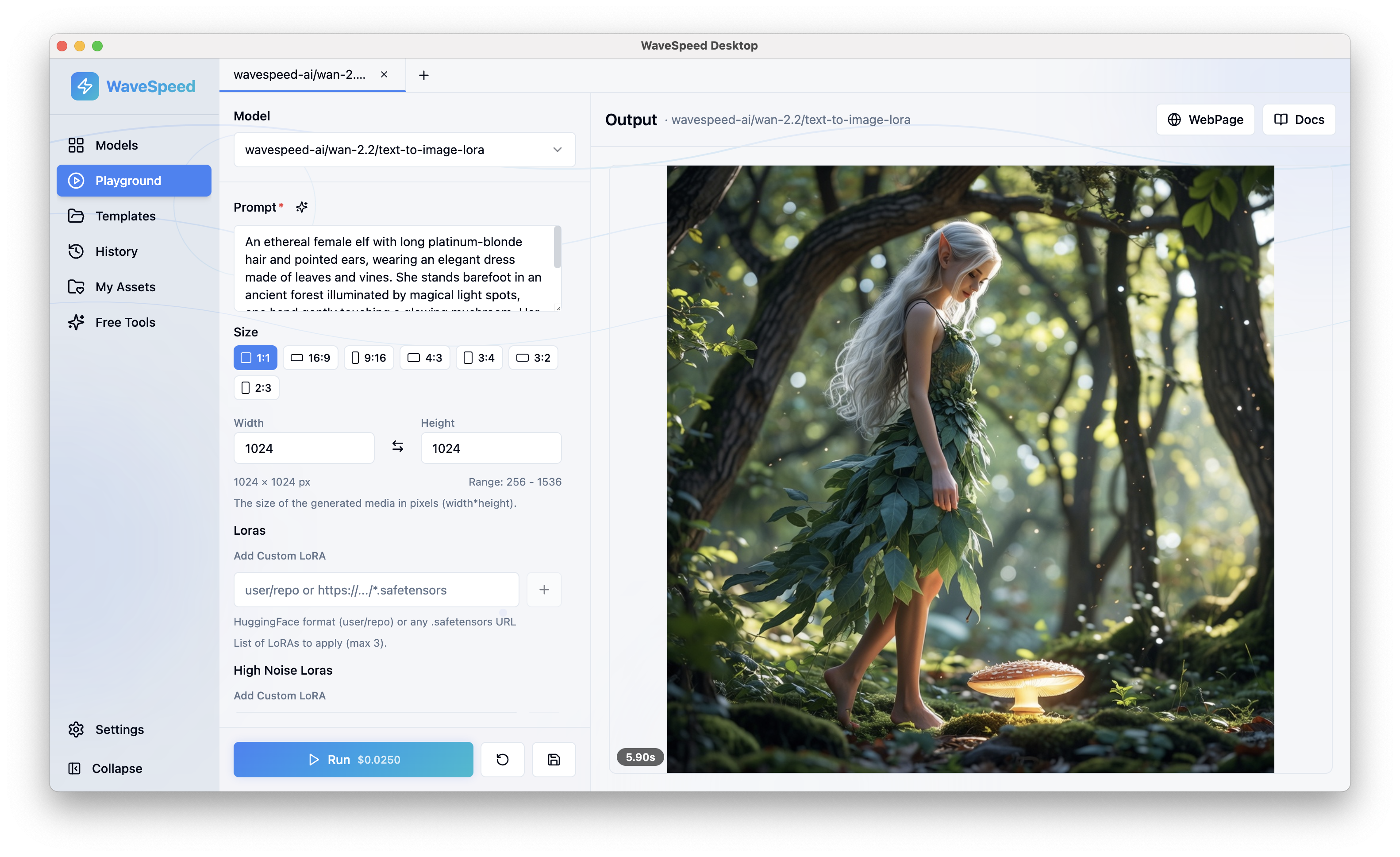

Commencer sur WaveSpeedAI

L’utilisation de Lipsync 1.9.0 Beta sur WaveSpeedAI est directe :

-

Téléchargez votre vidéo : Accédez à la page du modèle et téléchargez votre vidéo source. Pour de meilleurs résultats, utilisez des images avec un visage clairement visible—une vue de face ou trois quarts fonctionne mieux.

-

Ajoutez votre audio : Téléchargez votre piste de parole cible (MP3 ou WAV). Plus l’audio est propre, meilleurs sont les résultats—minimisez le bruit de fond pour une synchronisation optimale.

-

Sélectionnez votre mode de synchronisation : Choisissez comment vous voulez que le modèle gère tout décalage de longueur entre la vidéo et l’audio :

- Loop : Répétez le flux le plus court

- Bounce : Inversez et répétez

- Cut_off : Coupez pour correspondre

- Silence : Complétez avec du silence

- Remap : Étirement temporel pour correspondre

-

Exécutez et téléchargez : Cliquez sur Exécuter et recevez votre vidéo traitée avec des mouvements labiaux parfaitement synchronisés.

Pourquoi WaveSpeedAI ?

WaveSpeedAI offre les vitesses d’inférence les plus rapides pour Lipsync 1.9.0 Beta avec zéro démarrage à froid—vos travaux commencent à être traités immédiatement sans attendre l’initialisation du modèle. Notre infrastructure est optimisée pour les workloads de traitement vidéo, et nos tarifs transparents signifient que vous ne payez que pour le temps de traitement réel.

Tarification : 0,025 $ par seconde de vidéo traitée. Un clip de 30 secondes coûte seulement 0,75 $. Une minute complète coûte 1,50 $.

| Longueur du clip | Prix |

|---|---|

| 5 secondes | 0,13 $ |

| 10 secondes | 0,25 $ |

| 30 secondes | 0,75 $ |

| 60 secondes | 1,50 $ |

Conseils pour de meilleurs résultats

- Éclairage : Utilisez des gros plans propres et bien éclairés pour la synchronisation labiale la plus convaincante

- Cadrage : Évitez les mouvements de tête importants ou les visages partiellement hors du cadre

- Qualité audio : La parole propre avec un bruit de fond minimal produit la meilleure synchronisation

- Rythme de la parole : Pour le contenu doublé, faites correspondre les phrases et les pauses de votre audio traduit à peu près au timing de la performance originale

Faites passer votre contenu vidéo à l’échelle mondiale

Le marché de la synchronisation labiale par l’IA a évolué rapidement, Sync Labs menant constamment en qualité et réalisme. Lipsync 1.9.0 Beta représente l’aboutissement de années de recherche de l’équipe qui a créé le modèle fondateur Wav2Lip—maintenant disponible via l’infrastructure rapide et fiable de WaveSpeedAI.

Arrêtez de choisir entre la qualité et la commodité. Arrêtez de payer pour des acteurs de voix et du travail de synchronisation manuel coûteux. Commencez à créer du contenu multilingue qui semble et se sent natif pour chaque audience.

Essayez Sync Labs Lipsync 1.9.0 Beta sur WaveSpeedAI aujourd’hui →