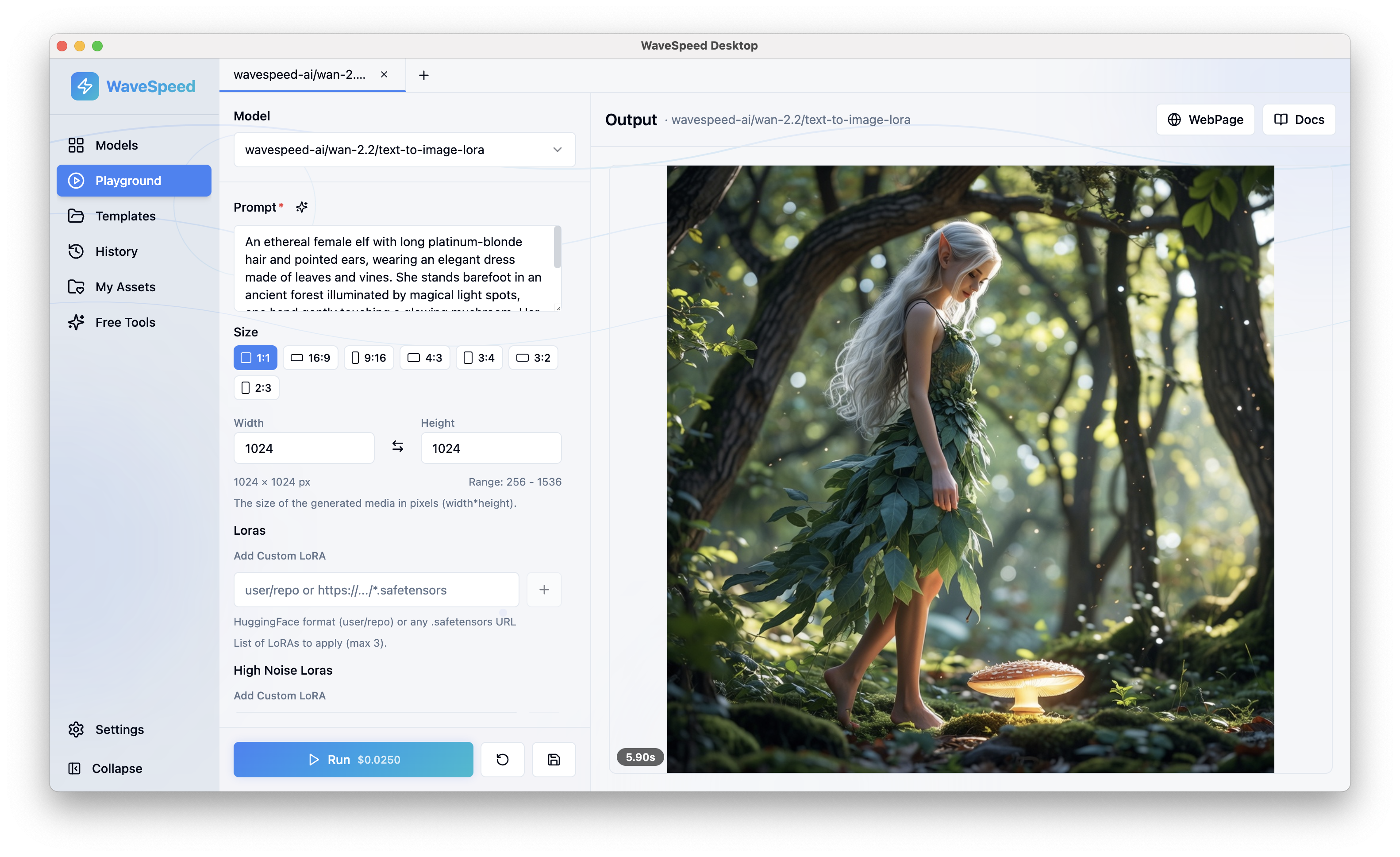

Présentation d'ElevenLabs Eleven V3 Timing sur WaveSpeedAI

Essayer Elevenlabs Eleven V3 Timing GRATUITEMENT

Présentation d’ElevenLabs Eleven V3 Timing sur WaveSpeedAI : Synthèse vocale de précision avec horodatages au niveau des mots

Le paysage de la génération audio alimentée par l’IA vient de faire un bond significatif en avant. WaveSpeedAI est ravi d’annoncer la disponibilité d’ElevenLabs Eleven V3 Timing—un modèle de synthèse vocale de pointe qui ne crée pas seulement une parole naturelle et réaliste, mais fournit également des métadonnées d’alignement précises pour chaque caractère et mot. Pour les développeurs construisant des systèmes de sous-titres, les éditeurs vidéo créant des effets karaoké et les créateurs concevant des avatars parlants, cela change tout.

Qu’est-ce qu’ElevenLabs Eleven V3 Timing ?

ElevenLabs s’est établi comme le leader du secteur en matière de qualité de synthèse vocale. Selon les classements HuggingFace TTS Arena, ElevenLabs a atteint une préférence auditeur de 75,3 % parmi près de 20 000 votes d’essais en aveugle, surpassant nettement des concurrents comme Google TTS et Amazon Polly.

Le modèle Eleven V3 Timing s’appuie sur cette base avec un ajout critique : les métadonnées d’alignement. Bien que les modèles TTS standard produisent uniquement de l’audio, cette version retourne des données de synchronisation détaillées qui mappent chaque caractère et mot à sa position exacte sur la chronologie audio. Vous obtenez à la fois un fichier MP3 de haute qualité et un objet JSON contenant les horodatages de début et de fin en secondes—créant un verrouillage étroit entre le texte et la parole.

Ce n’est pas simplement une amélioration progressive. C’est la différence entre avoir de l’audio et avoir de l’audio que votre application peut réellement comprendre et synchroniser.

Caractéristiques clés

Génération de parole naturelle et expressive

- Produit des voix réalistes avec une prononciation, un rythme et une intonation naturels

- Supporte la conscience contextuelle pour une plage émotionnelle et un ton précis

- Offre des accents authentiques dans plusieurs langues

- Qualité vocale leader du secteur vérifiée par des benchmarks indépendants

Métadonnées d’alignement précises

- Horodatages par caractère et par mot (heures de début et de fin en secondes)

- Métadonnées au format JSON aux côtés de la sortie audio

- Précision inférieure à la seconde pour une synchronisation précise

- Source unique de vérité pour les applications basées sur une chronologie

Personnalisation flexible de la voix

- voice_id : Choisissez parmi la vaste bibliothèque de voix d’ElevenLabs

- similarity (0-1) : Contrôlez la proximité de la sortie par rapport au timbre de la voix de base

- stability (0-1) : Équilibrez entre une livraison cohérente et une variation expressive

- use_speaker_boost : Normalisation de texte améliorée pour les nombres, dates et mesures

Sortie prête pour le développeur

- Fichiers audio MP3 haute qualité

- JSON d’alignement structuré pour une intégration immédiate

- Supporte les scripts jusqu’à 5 000 caractères par appel

- API REST avec un format requête/réponse simple

Cas d’usage concrets

Génération automatique de sous-titres

Générez des fichiers de sous-titres SRT ou VTT avec des codes temporels précis. Les métadonnées d’alignement fournissent des temps d’entrée/sortie exacts pour chaque mot, éliminant le processus manuel de synchronisation des sous-titres avec l’audio. Les créateurs de contenu peuvent produire des vidéos accessibles plus rapidement, et les équipes de localisation peuvent rationaliser leurs workflows multilingues.

Karaoké et surlignage des mots

Construisez des applications qui surlignent les mots en temps réel au fur et à mesure qu’ils sont prononcés. Les applications d’apprentissage des langues, les entraîneurs de lecture et les médias interactifs bénéficient tous de la synchronisation au niveau des mots. Les utilisateurs peuvent suivre l’audio, améliorant la compréhension et l’engagement.

Synchronisation labiale pour humains numériques et avatars

Alimentez les animations de personnages 2D et 3D avec des horodatages de mots et de phonèmes précis. Les données d’alignement commandent les mouvements de la bouche qui correspondent naturellement à l’audio—essentiel pour les assistants virtuels, les personnages de jeux, la production vidéo et les expériences interactives qui se sentent véritablement réactives.

Doublage vidéo et édition de voix off

Identifiez les points d’édition précis dans les vidéos existantes pour le remplacement de voix off. Les horodatages permettent l’insertion audio précise au cadre, rendant le travail professionnel de doublage et de localisation plus efficace. Les productions peuvent échanger du dialogue tout en maintenant une synchronisation parfaite avec le contenu visuel.

Applications éducatives et d’accessibilité

Créez des expériences de lecture en suivi, des exercices de shadowing et des outils d’entraînement à la prononciation. Les métadonnées de synchronisation permettent aux applications de fournir des retours en temps réel, de suivre la progression de l’utilisateur et de s’adapter aux besoins d’apprentissage individuels.

Commencer sur WaveSpeedAI

L’utilisation d’ElevenLabs Eleven V3 Timing via WaveSpeedAI est simple :

-

Préparez votre texte : Écrivez votre script (jusqu’à 5 000 caractères par requête). Une ponctuation claire améliore le rythme et la précision de l’alignement.

-

Sélectionnez une voix : Choisissez parmi la vaste bibliothèque de voix d’ElevenLabs en utilisant le paramètre

voice_id. -

Configurez les paramètres : Ajustez optionnellement

similarity,stabilityet activezuse_speaker_boostpour le contenu contenant des nombres ou des mesures. -

Passez votre appel API : Envoyez la requête via l’API REST de WaveSpeedAI.

-

Recevez votre sortie : Téléchargez le fichier audio et analysez le JSON d’alignement pour construire votre expérience synchronisée.

Pour les scripts plus longs nécessitant un contrôle au niveau des sections, divisez le contenu en plusieurs appels et assemblez les résultats sur votre chronologie.

Prêt à l’essayer ? Accédez au modèle directement à https://wavespeed.ai/models/elevenlabs/eleven-v3/timing.

Pourquoi WaveSpeedAI ?

L’exécution efficace des modèles d’IA compte. WaveSpeedAI fournit :

- Pas de démarrages à froid : Vos requêtes s’exécutent immédiatement sans attendre que l’infrastructure se mette en place

- Inférence rapide : L’infrastructure optimisée produit des résultats rapidement

- Tarification transparente : 0,10 $ par 1 000 caractères, facturés par blocs de 1 000 caractères

- API REST prête à l’emploi : Commencez l’intégration en quelques minutes, pas en jours

Vous obtenez la qualité vocale leader du secteur d’ElevenLabs combinée à l’infrastructure fiable et performante de WaveSpeedAI.

Conclusion

ElevenLabs Eleven V3 Timing représente une avancée significative dans la technologie de synthèse vocale. En combinant la synthèse vocale naturelle et expressive avec des métadonnées d’alignement précises, elle permet des applications qui étaient auparavant complexes à construire—ou simplement pas possibles.

Que vous créiez du contenu vidéo accessible, construisiez des outils d’apprentissage interactifs, animimez des personnages numériques ou développiez la prochaine génération d’expériences audiovisuelles, les données de synchronisation déverrouillent de nouvelles possibilités.

Le modèle est disponible maintenant sur WaveSpeedAI. Essayez ElevenLabs Eleven V3 Timing aujourd’hui et découvrez ce que la synthèse vocale de précision peut faire pour vos projets.