Comment Freepik a dimensionné la génération de médias FLUX à des millions de requêtes par jour avec DataCrunch et WaveSpeed

Comment Freepik a augmenté la génération multimédia FLUX à des millions de requêtes par jour avec DataCrunch et WaveSpeed

Résumé

Freepik travaille avec DataCrunch depuis le début de 2024 pour intégrer la génération multimédia de pointe dans sa suite d’IA et augmenter ses capacités au-delà de millions de requêtes d’inférence par jour. DataCrunch fournit à Freepik son infrastructure GPU de pointe et ses services d’inférence gérés, offrant les capacités suivantes :

- Orchestration GPU gérée

- Mise à l’échelle élastique et démarrages à froid quasi nuls

- Service de modèles haute vélocité avec WaveSpeed

- Contact direct pour un support d’experts et une collaboration stratégique Les clients de Freepik génèrent plus de 60 millions d’images par mois, avec une portion importante de ces requêtes rendue possible par l’infrastructure et les services de DataCrunch.

1. Profil du client

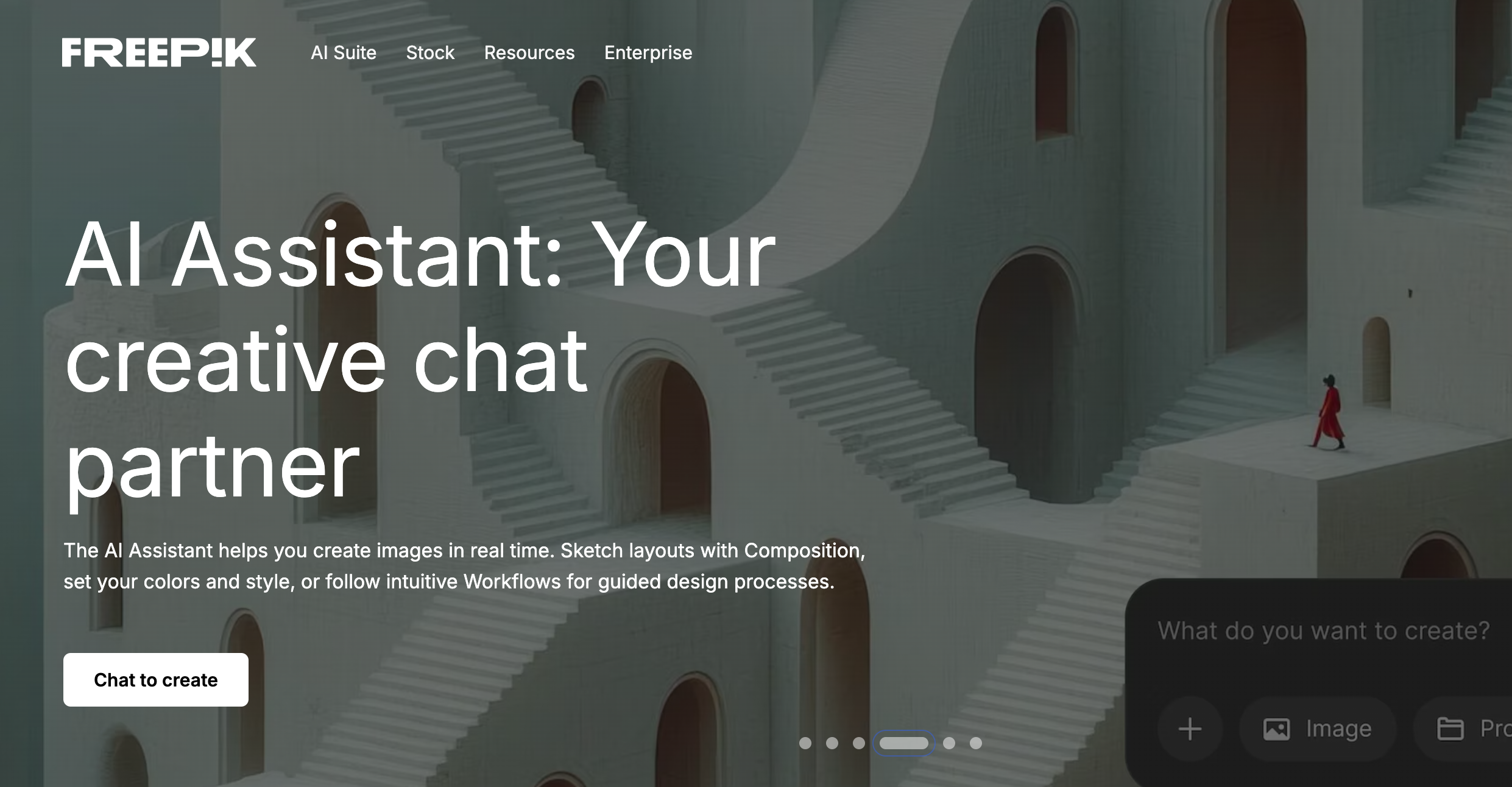

Freepik est une suite créative de pointe alimentée par l’IA qui combine des outils d’IA générative avancés avec plus de 250 millions d’actifs en stock organisés pour rationaliser la création de contenu de haute qualité.

Au début de 2024, Freepik a redéfini son modèle commercial pour exploiter l’IA générative pour créer du contenu multimédia de haute qualité. Freepik a commencé son voyage dans la génération d’images avec des modèles tels que Stable Diffusion XL et des points de terminaison expérimentaux. En 2025, Freepik a affiné son approche pour adopter des modèles comme FLUX et augmenter son infrastructure au niveau de la production tout en s’adaptant à une base d’utilisateurs en croissance rapide.

La Suite d’IA de Freepik propose un générateur d’images IA, qui utilise des modèles tels que FLUX pour produire des images photoréalistes à partir d’invites textuelles (T2I) ou d’images (I2I), et un générateur de vidéos IA, alimenté par des modèles tels que Google DeepMind Veo 2, pour créer des vidéos à partir de texte ou d’images. Ces fonctionnalités ont été conçues pour être intuitives tout en privilégiant la personnalisation du style et les flux de travail guidés.

La suite d’IA de Freepik a connu :

- 80 millions de visiteurs par mois

- 600 mille utilisateurs abonnés

- 60 millions d’images générées par mois

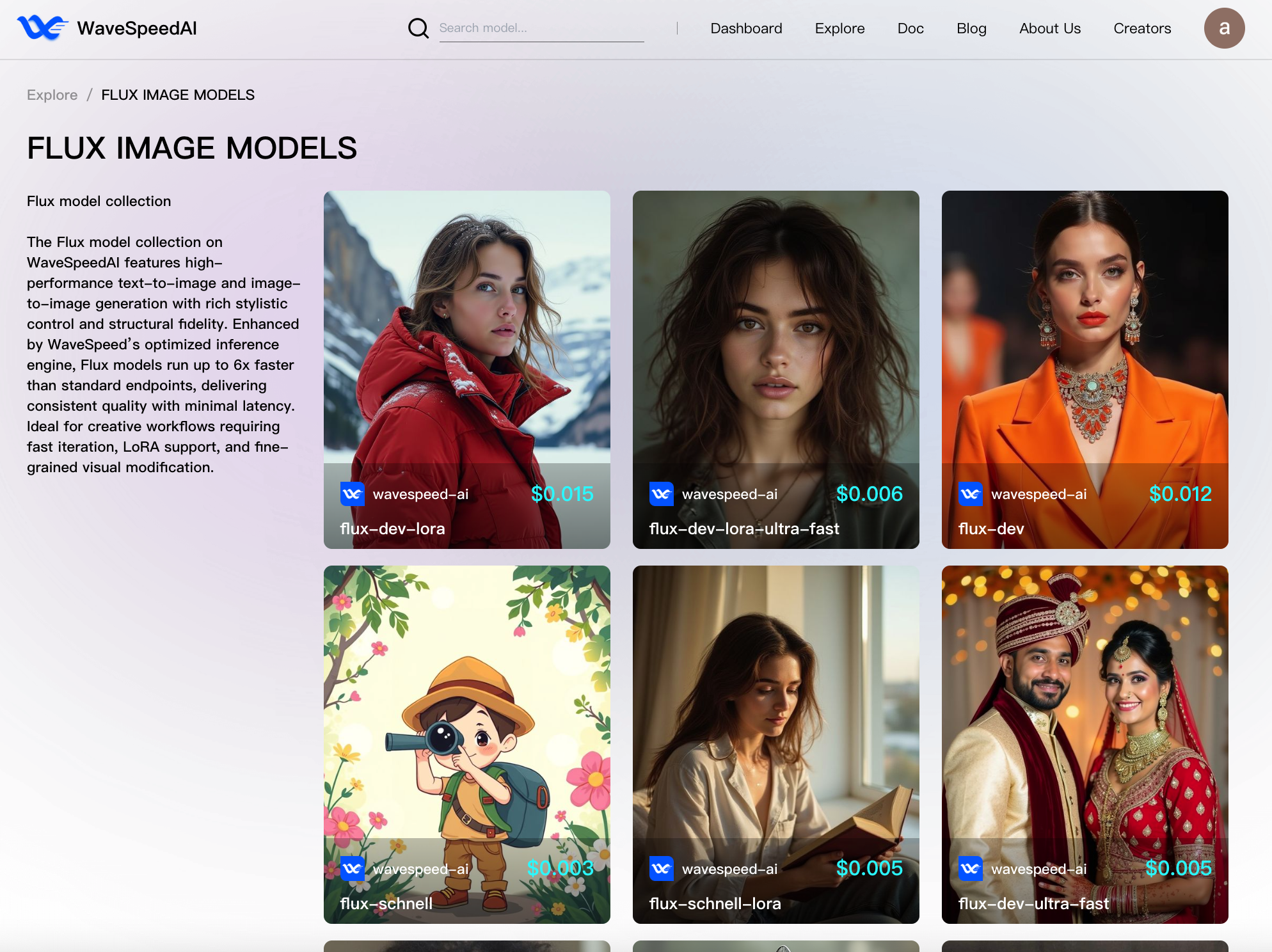

Une portion importante de ces requêtes d’inférence concerne la suite de modèles FLUX avec les points de terminaison d’inférence gérés par DataCrunch et utilisant le moteur d’inférence de WaveSpeed :

- FLUX Dev

- FLUX Tools (par exemple, inpainting)

2. Génération multimédia rentable : FLUX Dev

2.1. Défis initiaux

La mise à l’échelle de l’infrastructure n’est rarement une tâche facile. Mettre à l’échelle l’infrastructure tout en accueillant une base d’utilisateurs en croissance exponentielle, en répondant aux pics d’utilisation quotidiens et en optimisant pour le coût et la vitesse d’inférence est pratiquement impossible. Alors que Freepik s’est lancé dans la construction d’un produit et d’une expérience client de classe mondiale, son infrastructure de génération d’images devait être à l’avant-garde des performances tout en répondant aux exigences suivantes :

- Maintenir une latence inférieure à la plage de 2-6 secondes (p50)

- Optimiser le débit/$ (image par heure par calcul)

- Éviter toute régression de qualité perceptible par rapport à la ligne de base officielle non optimisée

Pour répondre à ces exigences, Freepik doit fonctionner à la pointe de l’efficacité, car même des fractions de centimes et une utilisation GPU plus optimale par génération se traduiraient par des économies de coûts importantes à cette échelle.

2.2. Approche technique

En travaillant avec DataCrunch sur la construction et la mise à l’échelle de son infrastructure d’inférence, Freepik peut concentrer tous ses efforts sur l’amélioration de la qualité du produit et l’offre d’une expérience utilisateur de classe mondiale. DataCrunch a également permis à Freepik de s’adapter aux avancées rapides en matière de génération d’images. DataCrunch a continuellement fourni une communication directe entre ses ingénieurs et Freepik, permettant une collaboration et des ajustements rapides. Cette communication directe était nécessaire pour soutenir l’échelle et la croissance que Freepik a connu, et pour éliminer tout retard ou possibilité de malentendu.

« Avoir un contact direct entre nos équipes d’ingénierie nous permet de nous déplacer incroyablement rapidement. Pouvoir déployer n’importe quel modèle à l’échelle est exactement ce dont nous avons besoin dans cette industrie qui évolue rapidement. DataCrunch nous permet de déployer des modèles personnalisés rapidement et sans effort. » – Iván de Prado, responsable de l’IA chez Freepik

En conséquence, Freepik a bénéficié d’un service de modèles rentable dans sa suite d’IA tout en atteignant le débit/$ cible et la latence. Nos efforts chez DataCrunch visaient à éviter le piège « vitesse d’inférence à tout prix », qui s’accompagne généralement de compromis tels que la dégradation de la sortie et la mise à l’échelle instable. Pour y parvenir, nous avons mené une recherche approfondie sur les optimisations sans perte qui préservent les capacités des modèles, suivie d’une évaluation rigoureuse :

- Évaluation multi-métriques : Utilisant la combinaison de DreamSim, FID, CLIP, ImageReward, et Aesthetic

- Évaluation humaine : Freepik a mené une évaluation extensive via des arènes A/B, en comparaison avec la ligne de base et d’autres fournisseurs d’inférence.

- Diversité des invites : Évaluation de catégories d’invites diverses en se concentrant sur les objets, les scènes et les concepts abstraits.

À partir de 2025, la recherche en co-conception matériel-logiciel DataCrunch-WaveSpeed nous a permis de repousser davantage l’efficacité d’inférence pratique maximale offerte à Freepik tout en utilisant les forces de base de chaque organisation :

- L’infrastructure GPU DataCrunch et les conteneurs sans serveur avec mise à l’échelle automatique sur le cluster Kubernetes interne, la mise en réseau haut débit et le stockage d’objets à faible latence.

- Le moteur d’inférence WaveSpeed avec un compilateur ML interne, des noyaux CUDA personnalisés et fusionnés, une quantification lossless avancée, la mise en cache d’activation DiT (par exemple, AdaCache), et des serveurs d’inférence légers avec une surcharge négligeable.

3. Benchmarking d’inférence : méthodologie et résultats

Métriques clés : Temps d’inférence moyen et latence (p99), coût par génération et débit par heure.

Tous les résultats suivants ont été obtenus avec une taille de monde de 1 appareil. L’optimisation de chaque point de terminaison pour l’efficacité nous a permis d’allouer dynamiquement les ressources disponibles en fonction du trafic de Freepik à un moment donné et des exigences (par exemple, les niveaux d’utilisateurs).

| Point de terminaison | Paramètres d’entrée | Temps d’inférence GPU (sec) | débit par GPU/h |

|---|---|---|---|

| flux-dev | Size = 1024x1024, steps = 28, optional cache = 0.1 | 4.4 | 818.2 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = None | 3.3 | 1091 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = 0.1 | 2.2 | 1636 |

| flux-dev-fast | Size = 1024x1024, steps = 28, optional cache = None | 1.64 | 2184 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = None | 1.648 | 2184 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = 0.1 | 1.045 | 3445 |

| flux-dev-ultra | Size = 1024x1024, steps = 28, optional cache = 0.16 | 0.768 | 4688 |

4. Solution technique : Infrastructure GPU de niveau production

L’infrastructure GPU DataCrunch fournit une base de niveau production pour les systèmes d’IA générative à grande échelle, le moteur d’optimisation WaveSpeed repoussant davantage les limites de l’efficacité.

- Orchestration GPU gérée : La gestion fine des ressources GPU est fournie via un cluster Kubernetes interne, permettant à WaveSpeed de contrôler l’allocation des ressources pour l’inférence sans se soucier de la gestion de l’infrastructure ou du plongement dans l’infrastructure en tant que code.

- Mise à l’échelle élastique : Les conteneurs sans serveur ont été personnalisés pour se mettre à l’échelle automatiquement de zéro à plus de 500 instances GPU en fonction du nombre de requêtes entrantes. Cette capacité est cruciale pour absorber les pics de trafic quotidiens sans mise en file d’attente ou suppression de requêtes, ainsi que la mise à l’échelle à zéro en cas d’inactivité pour éviter les coûts inutiles.

- Démarrages à froid quasi nuls : La latence des démarrages à froid a été considérablement réduite grâce aux compilations de préchauffage, aux temps d’extraction d’images plus rapides et à la mise en cache des conteneurs, se rapprochant de la vraie performance lambda pour les charges de travail GPU.

- Service de modèles haute vélocité : Les stockages optimisés et les structures réseau ont considérablement réduit le temps consacré au chargement des poids du modèle et à l’extraction des images Docker. Ceci est particulièrement crucial pour les déploiements FLUX LoRA puisque les poids LoRA doivent être mis en cache et déplacés à chaque instance GPU. En outre, le système de fichiers partagé DataCrunch augmente davantage la vélocité de la distribution des modèles et réduit les frais généraux de transfert de données en permettant à plusieurs instances de lire et d’écrire dans le même référentiel de fichiers centralisé.

5. Résultats commerciaux : économies de coûts et avantages stratégiques

DataCrunch, travaillant conjointement avec WaveSpeed, a permis à Freepik de mettre à l’échelle la génération d’images avec les modèles FLUX Dev tout en minimisant les coûts d’inférence. En plus des économies de coûts directes, le partenariat stratégique a permis à une grande fraction des utilisateurs de Freepik d’accéder aux modèles FLUX avec des quotas de génération plus élevés. L’équipe de DataCrunch a rigoureusement évalué et assuré la qualité de la sortie tout en exploitant une infrastructure de calcul hétérogène en appliquant des optimisations tenant compte du matériel. L’une des principales conclusions était que l’inférence durable et évolutive nécessite une compréhension des systèmes ML sous différentes perspectives :

- Optimisations tenant compte du GPU (par exemple, noyaux CUDA personnalisés B200)

- Tests et évaluations rigoureux

- Intégration d’infrastructure (c’est-à-dire, mise à l’échelle automatique, démarrages à froid nuls, réglage du réseau) Alors que Freepik vise un trafic et des volumes d’inférence plus élevés avec son nouveau plan entreprise, DataCrunch continuera à appliquer cette approche réussie pour atteindre des performances de mise à l’échelle continues.

6. Prédictions futures : Qu’y a-t-il à venir pour la génération multimédia

La génération d’images à partir d’invites textuelles ou de conditionnement d’images est devenue insuffisante pour répondre à la demande croissante de capacités de contrôle et d’édition dans les environnements professionnels, tels qu’utilisés par les artistes numériques et les agences de publicité. Avec la sortie de FLUX, Black Forest Labs a fait un bond géant dans la qualité de la génération d’images. Nous nous attendons à ce que FLUX.1 Kontext [dev] crée un point d’inflexion similaire pour l’édition d’images, avec ses taux d’adoption dépassant ceux du modèle FLUX. Les histoires, telles que la génération d’images OpenAI 4o, confirment qu’il existe une forte demande pour les modèles avec un haut degré de manœuvrabilité, un conditionnement facile avec des images d’entrée, une cohérence des personnages et une forte adhésion aux invites. Avec la sortie de FLUX.1 Kontext [max] et [pro], Black Forest Labs a démontré qu’ils sont capables de reproduire ces capacités tout en étant plus rentables. À l’avenir, DataCrunch prévoit d’aller au-delà de la génération d’images et vers les flux de travail de bout en bout. Les projets de recherche et développement en cours se sont concentrés sur :

- Intégration évolutive et rentable de la génération vidéo SOTA avec des modèles comme Alibaba WAN 2.1 et VACE

- Modèles de suramplification d’images et de vidéos

- Réduction de la complexité de la construction de produits multimédia agentiques

- Lancement des points de terminaison d’inférence FLUX Dev (modèle de base, LoRA, outils) dans la plateforme cloud DataCrunch – à bientôt

Essayez FLUX Dev et d’autres modèles dès maintenant !

🔗FLUX-dev

🔗FLUX-dev-ultra-fast

🔗FLUX-dev-lora

🔗Collection FLUX

🔗Wan-2.1-14b-vace

🔗Seedance 1.0