Da Replicate sich Cloudflare anschließt, brauchen Entwickler mehr denn je Stabilität – Warum Tausende ihre multimodalen Workloads zu WaveSpeedAI verlagern

Die KI-Welt bewegt sich schnell – aber manchmal in Richtungen, die Produktteams nicht vorhersehen.

Wenn eine große multimodale KI-Plattform übernommen wird, treten schnell Welleneffekte auf: unsichere Preisgestaltung, verschobene Prioritäten, neu eingeführte Einschränkungen und eine Roadmap, die möglicherweise nicht mehr den Entwicklern dient, die darauf aufgebaut haben.

Für Teams, die multimodale Workloads betreiben – insbesondere Bild- und Videogenerierung – ist Unsicherheit nicht nur unbequem. Sie ist teuer. Sie ist riskant. Und sie wirkt sich direkt auf die Produktzuverlässigkeit aus.

Dies ist der Moment, in dem sich viele Teams fragen: „Ist meine KI-Infrastruktur auf die nächsten Schritte meines Produkts ausgerichtet?“

Eine wachsende Zahl beantwortet diese Frage mit einem Wechsel zu WaveSpeedAI.

Ein neuer Standard etabliert sich: Hochgeschwindigkeits- und hochstabile multimodale Inferenz

WaveSpeedAI wurde nicht als allgemeine Hosting-Plattform für Modelle entwickelt. Es wurde als multimodaler Beschleunigungsmotor konzipiert, der durchgängig für Produktions-Workloads, vorhersagbare Latenz und reale Skalierbarkeit optimiert ist.

Teams, die zu WaveSpeedAI wechseln, nennen durchweg drei Unterschiede, die sie sofort bemerken:

1. Enorme Geschwindigkeit – angetrieben von unserer benutzerdefinierten Inferenz-Engine

Unsere Architektur führt mehrere Inferenzschritte zusammen und plant GPU-Workloads dynamisch, was Folgendes ermöglicht:

- Bis zu 3-mal schnellere Generierung als bei typischen Plattformen

- Hochstabile Leistung, selbst bei hoher Parallelität

- Branchenführender Durchsatz für anspruchsvolle Video-Workloads

Allein das verändert für videozentrierte Produkte, was möglich ist.

2. Vorhersagbarkeit – die am meisten unterschätzte Anforderung an KI-Infrastruktur

Sie brauchen die Gewissheit, dass die Leistung von morgen der von heute entspricht.

WaveSpeedAI stellt dies sicher durch:

- Konsistente, niedrige Latenzleistung über alle Modelle hinweg

- Schnelle Updates, die auf die neuesten multimodalen Veröffentlichungen abgestimmt sind

- Produktionsreife Verfügbarkeits- und Leistungsgarantien

Ihre Benutzer sollten niemals Instabilität erleben, die durch Ihren KI-Stack verursacht wird.

3. Ein Modell-Ökosystem für Entwickler, nicht für geschlossene Plattformen

WaveSpeedAI integriert führende Bild- und Videomodelle – einschließlich WAN, Veo, Seedance, Hunyuan, Kling, MiniMax, HiDream und mehr – jedes direkt auf unserer Engine optimiert.

Sie erhalten nicht nur Zugriff. Sie erhalten die schnellsten und produktionsreifsten Versionen dieser Modelle.

Ein reibungsloser Migrationspfad – denn kein Team will Reibungsverluste

Plattformen wie Replicate haben die API-First-Entwicklung einfach gemacht.

WaveSpeedAI setzt diese Einfachheit fort – mit deutlich höherer Leistung darunter.

Teams, die zu WaveSpeedAI migrieren, profitieren von:

- Einer einheitlichen API, die darauf ausgelegt ist, bestehende Endpunkte mit minimalen Codeänderungen zu ersetzen

- Automatischer GPU-Optimierung, die die Auslastung um bis zu 300 % verbessern kann

- Optionen für öffentliche API- und private Cluster-Bereitstellungen für sicherheitssensible Workloads

- Praktischer Unterstützung, um bestehende Arbeitsabläufe nahtlos abzubilden

Eine Migration sollte Ihre Roadmap nicht verlangsamen. Wir stellen sicher, dass sie es nicht tut.

Warum Teams jetzt umsteigen

Bei Start-ups, Plattformen und KI-Teams in Unternehmen sind die Beweggründe bemerkenswert konsistent:

- Bedarf an langfristiger Plattformstabilität

- Anforderungen an schnellere Inferenz und besseren Durchsatz

- Druck, Kosten zu kontrollieren, ohne die Leistung zu beeinträchtigen

- Wunsch nach einem Partner, der sich ausschließlich auf die multimodale Generierung konzentriert

WaveSpeedAI repräsentiert mehr als nur ein Werkzeug – es repräsentiert eine Richtung. Ein Bekenntnis zu Geschwindigkeit, Transparenz, Performance-Engineering und langfristiger Unterstützung für multimodale Entwickler.

Wenn die KI-Welt in ihre „Inferenz-First-Ära“ eintritt, glauben viele, dass die nächste Generation multimodaler Produkte auf WaveSpeedAI aufgebaut wird.

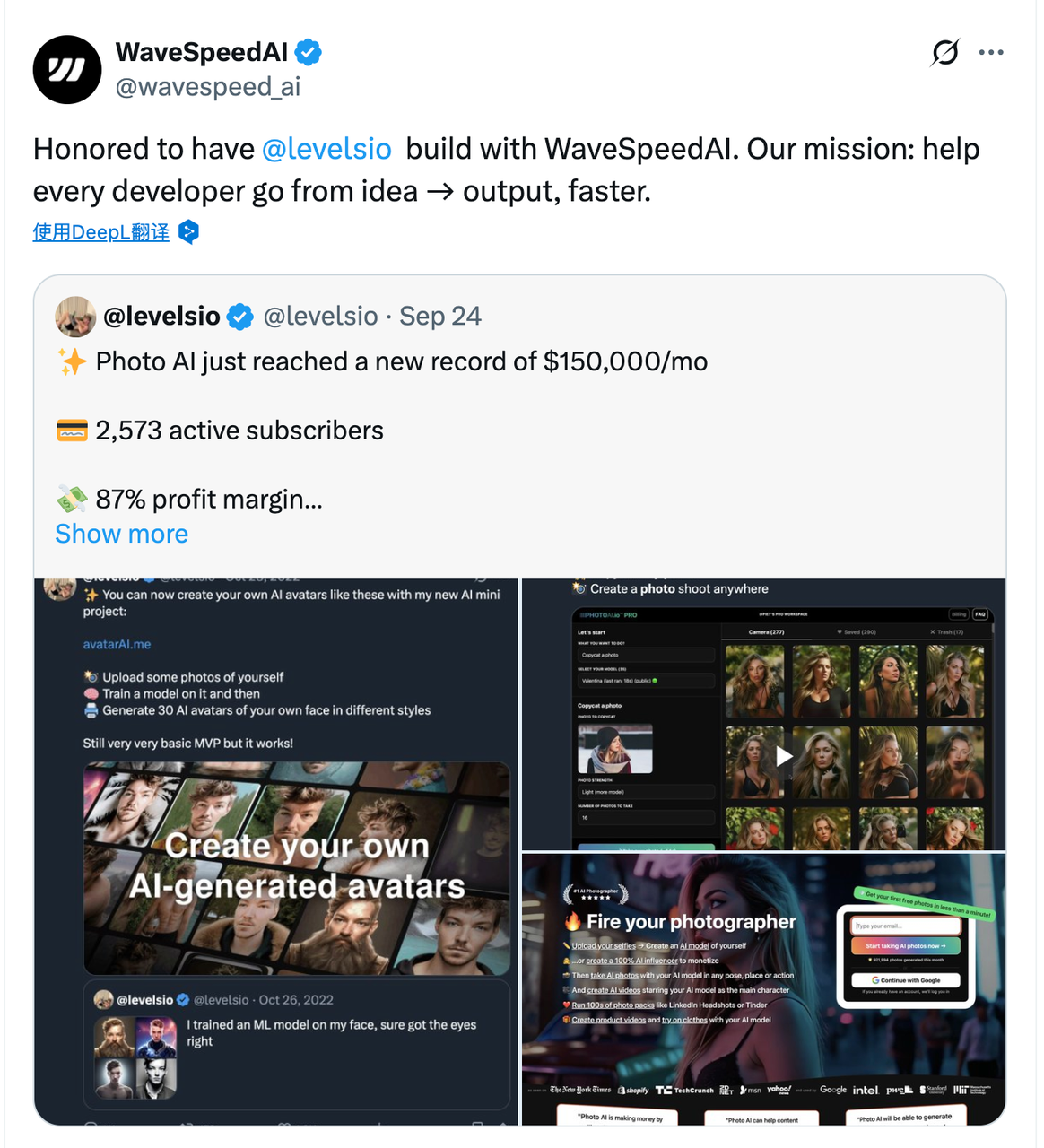

Fallbeispiel: Vertrauen der Community

Selbst die anspruchsvollsten Entwickler vollziehen den Wechsel. Pieter Levels – eine bekannte Persönlichkeit in der Indie-Hacker- und Digital-Nomad-Welt – hat diesen Wandel selbst erlebt.

Auf der Suche nach der besten Mischung aus Geschwindigkeit und Stabilität probierte er Replicate, dann Fal und entschied sich schließlich für WaveSpeedAI. Wenn unabhängige Kreative, denen Effizienz wichtig ist, eine Plattform wählen, entscheiden sie sich für diejenige, die einfach am besten funktioniert.

Bauen Sie eine Grundlage, die Sie kontrollieren

Wenn Sie Alternativen evaluieren, eine Migration planen oder einfach nur Ihre Arbeitslast bewerten möchten, kann unser Team Sie durch das beste Setup für Ihr Produkt führen.

Kontaktieren Sie uns

Email | Discord Community | X (Twitter) | Open Source Projects | Instagram

Ob Sie proaktiv handeln oder auf Plattformänderungen reagieren, WaveSpeedAI gibt Ihrem multimodalen Stack die Geschwindigkeit, Stabilität und Klarheit, die er verdient.

Ihre Benutzer sollten nicht warten müssen – und Sie auch nicht.

© 2025 WaveSpeedAI. All rights reserved.